Wenn Sie einen Datenspeicher erstellen und Daten für die Suche aufnehmen möchten, rufen Sie den Abschnitt für die Quelle auf, die Sie verwenden möchten:

- Datenspeicher mit Websiteinhalten erstellen

- Aus BigQuery importieren

- Aus Cloud Storage importieren

- Synchronisierung über Google Drive

- Aus Gmail synchronisieren (öffentliche Vorschau)

- Synchronisierung aus Google Sites (öffentliche Vorschau)

- Aus Google Kalender synchronisieren (öffentliche Vorschau)

- Aus Google Groups synchronisieren (öffentliche Vorschau)

- Personendaten synchronisieren (öffentliche Vorschau)

- Aus Cloud SQL importieren

- Aus Spanner importieren (öffentliche Vorschau)

- Aus Firestore importieren

- Aus Bigtable importieren (öffentliche Vorschau)

- Aus AlloyDB for PostgreSQL importieren (öffentliche Vorschau)

- Strukturierte JSON-Daten mit der API hochladen

- Datenspeicher mit Terraform erstellen

Wenn Sie stattdessen Daten aus einer Datenquelle eines Drittanbieters synchronisieren möchten, lesen Sie den Hilfeartikel Datenquelle eines Drittanbieters verbinden.

Datenspeicher mit Websiteinhalten erstellen

Gehen Sie so vor, um einen Datenspeicher zu erstellen und Websites zu indexieren.

Wenn Sie einen Website-Datenspeicher nach dem Erstellen verwenden möchten, müssen Sie ihn an eine App anhängen, für die Unternehmensfunktionen aktiviert sind. Sie können die Enterprise-Version für eine App aktivieren, wenn Sie sie erstellen. Dadurch fallen zusätzliche Kosten an. Weitere Informationen finden Sie unter Such-App erstellen und Erweiterte Funktionen.

Console

So erstellen Sie mit der Google Cloud Console einen Datenspeicher und indexieren Websites:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

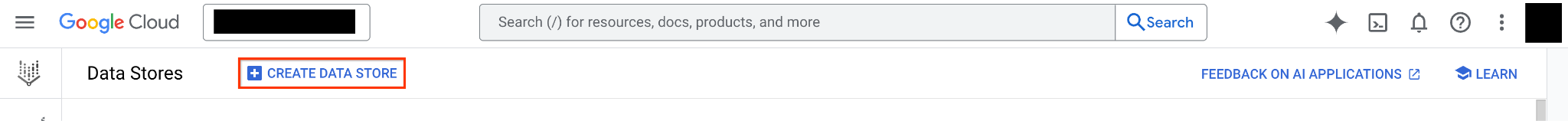

Klicken Sie im Navigationsmenü auf Datenspeicher.

Klicken Sie auf Datenspeicher erstellen.

Wählen Sie auf der Seite Quelle die Option Websiteinhalte aus.

Wählen Sie aus, ob Sie die erweiterte Websiteindexierung für diesen Datenspeicher aktivieren möchten. Diese Option kann später nicht mehr aktiviert oder deaktiviert werden.

Die erweiterte Websiteindexierung bietet zusätzliche Funktionen wie die Zusammenfassung der Suche, die Suche mit weiterführenden Fragen und extraktive Antworten. Für die erweiterte Websiteindexierung fallen zusätzliche Kosten an. Außerdem müssen Sie die Domaininhaberschaft für jede Website bestätigen, die Sie indexieren. Weitere Informationen finden Sie unter Erweiterte Websiteindexierung und Preise.

Geben Sie im Feld Einzuschließende Websites die URL-Muster ein, die den Websites entsprechen, die Sie in Ihren Datenspeicher aufnehmen möchten. Geben Sie pro Zeile ein URL-Muster ohne Kommatrennzeichen an. Beispiel:

example.com/docs/*Optional: Geben Sie im Feld Auszuschließende Websites URL-Muster ein, die Sie aus Ihrem Datenspeicher ausschließen möchten.

Ausgeschlossene Websites haben Vorrang vor eingeschlossenen Websites. Wenn Sie also

example.com/docs/*einbeziehen, aberexample.comausschließen, werden keine Websites indexiert. Weitere Informationen finden Sie unter Websitedaten.Klicken Sie auf Weiter.

Wählen Sie einen Speicherort für den Datenspeicher aus.

- Wenn Sie einen grundlegenden Website Search-Datenspeicher erstellen, wird dieser immer auf Global festgelegt.

- Wenn Sie einen Datenspeicher mit erweiterter Websiteindexierung erstellen, können Sie einen Standort auswählen. Da die indexierten Websites öffentlich sein müssen, empfiehlt Google dringend, global als Standort auszuwählen. So wird die maximale Verfügbarkeit aller Such- und Antwortdienste gewährleistet und die Einschränkungen regionaler Datenspeicher werden aufgehoben.

Geben Sie einen Namen für den Datenspeicher ein.

Klicken Sie auf Erstellen. In Vertex AI Search wird Ihr Datenspeicher erstellt und auf der Seite Datenspeicher angezeigt.

Wenn Sie Informationen zu Ihrem Datenspeicher aufrufen möchten, klicken Sie in der Spalte Name auf den Namen des Datenspeichers. Die Seite Ihres Datenspeichers wird angezeigt.

- Wenn Sie die erweiterte Websiteindexierung aktiviert haben, wird eine Warnung angezeigt, in der Sie aufgefordert werden, die Domains in Ihrem Datenspeicher zu bestätigen.

- Wenn Sie ein Kontingentdefizit haben (die Anzahl der Seiten auf den von Ihnen angegebenen Websites überschreitet das Kontingent „Anzahl der Dokumente pro Projekt“ für Ihr Projekt), wird eine zusätzliche Warnung angezeigt, in der Sie aufgefordert werden, Ihr Kontingent zu erhöhen.

Folgen Sie der Anleitung auf der Seite Website-Domains bestätigen, um die Domains für die URL-Muster in Ihrem Datenspeicher zu bestätigen.

So führen Sie ein Upgrade Ihres Kontingents durch:

- Klicken Sie auf Kontingent aktualisieren. Die Seite IAM & Verwaltung der Google Cloud Console wird angezeigt.

- Folgen Sie der Anleitung unter Höheres Kontingentlimit anfordern in der Google Cloud Dokumentation. Das zu erhöhende Kontingent ist Anzahl der Dokumente im Dienst Discovery Engine API.

- Nachdem Sie die Anfrage für ein höheres Kontingentlimit gesendet haben, kehren Sie zur Seite KI-Anwendungen zurück und klicken Sie im Navigationsmenü auf Datenspeicher.

- Klicken Sie in der Spalte Name auf den Namen des Datenspeichers. In der Spalte Status wird angezeigt, dass die Indexierung für die Websites, die das Kontingent überschritten haben, noch läuft. Wenn in der Spalte Status für eine URL Indexiert angezeigt wird, sind für diese URL oder dieses URL-Muster erweiterte Funktionen für die Website-Indexierung verfügbar.

Weitere Informationen finden Sie auf der Seite „Kontingente und Limits“ unter Kontingent für die Indexierung von Webseiten.

Python

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Python API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Websites importieren

Nächste Schritte

Wenn Sie Ihren Website-Datenspeicher an eine App anhängen möchten, erstellen Sie eine App mit aktivierten Enterprise-Funktionen und wählen Sie Ihren Datenspeicher gemäß der Anleitung unter Such-App erstellen aus.

Wenn Sie die erweiterte Websiteindexierung aktiviert haben, können Sie strukturierte Daten verwenden, um Ihr Schema zu aktualisieren.

Eine Vorschau der Suchergebnisse nach der Einrichtung Ihrer App und Ihres Datenspeichers finden Sie unter Suchergebnisse abrufen.

Aus BigQuery importieren

Mit Vertex AI Search können Sie BigQuery-Daten durchsuchen.

Sie haben zwei Möglichkeiten, Datenspeicher aus BigQuery-Tabellen zu erstellen:

Einmalige Aufnahme: Sie importieren Daten aus einer BigQuery-Tabelle in einen Datenspeicher. Die Daten im Datenspeicher ändern sich nur, wenn Sie sie manuell aktualisieren.

Regelmäßige Aufnahme: Sie importieren Daten aus einer oder mehreren BigQuery-Tabellen und legen eine Synchronisierungshäufigkeit fest, die bestimmt, wie oft die Datenspeicher mit den neuesten Daten aus dem BigQuery-Dataset aktualisiert werden.

In der folgenden Tabelle werden die beiden Möglichkeiten zum Importieren von BigQuery-Daten in Vertex AI Search-Datenspeicher verglichen.

| Einmalige Aufnahme | Regelmäßige Aufnahme |

|---|---|

| Allgemein verfügbar (GA) | Öffentliche Vorschau |

| Die Daten müssen manuell aktualisiert werden. | Die Daten werden automatisch alle 1, 3 oder 5 Tage aktualisiert. Daten können nicht manuell aktualisiert werden. |

| Vertex AI Search erstellt einen einzelnen Datenspeicher aus einer Tabelle in BigQuery. | Vertex AI Search erstellt einen Datenconnector für ein BigQuery-Dataset und einen Datenspeicher (als Entitätsdatenspeicher bezeichnet) für jede angegebene Tabelle. Für jeden Datenconnector müssen die Tabellen denselben Datentyp (z. B. strukturiert) haben und sich im selben BigQuery-Dataset befinden. |

| Daten aus mehreren Tabellen können in einem Datenspeicher kombiniert werden, indem zuerst Daten aus einer Tabelle und dann weitere Daten aus einer anderen Quelle oder BigQuery-Tabelle aufgenommen werden. | Da der manuelle Datenimport nicht unterstützt wird, können die Daten in einem Entitätsdatenspeicher nur aus einer BigQuery-Tabelle stammen. |

| Die Zugriffssteuerung für Datenquellen wird unterstützt. | Die Zugriffssteuerung für Datenquellen wird nicht unterstützt. Die importierten Daten können Zugriffssteuerungen enthalten, diese werden jedoch nicht berücksichtigt. |

| Sie können einen Datenspeicher entweder über dieGoogle Cloud Console oder die API erstellen. | Sie müssen die Console verwenden, um Daten-Connectors und die zugehörigen Datenspeicher für Entitäten zu erstellen. |

| CMEK-kompatibel. | CMEK-kompatibel. |

Einmaliger Import aus BigQuery

Wenn Sie Daten aus einer BigQuery-Tabelle aufnehmen möchten, gehen Sie so vor, um einen Datenspeicher zu erstellen und Daten entweder über die Google Cloud Konsole oder die API aufzunehmen.

Bevor Sie Ihre Daten importieren, lesen Sie den Artikel Daten für die Aufnahme vorbereiten.

Console

So nehmen Sie Daten aus BigQuery über die Google Cloud Konsole auf:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Rufen Sie die Seite Datenspeicher auf.

Klicken Sie auf Datenspeicher erstellen.

Wählen Sie auf der Seite Quelle die Option BigQuery aus.

Wählen Sie im Abschnitt Welche Art von Daten importieren Sie? den Datentyp aus, den Sie importieren möchten.

Wählen Sie im Abschnitt Synchronisierungshäufigkeit die Option Einmal aus.

Klicken Sie im Feld BigQuery-Pfad auf Durchsuchen, wählen Sie eine Tabelle aus, die Sie für die Aufnahme vorbereitet haben, und klicken Sie dann auf Auswählen. Alternativ können Sie den Tabellenspeicherort direkt in das Feld BigQuery-Pfad eingeben.

Klicken Sie auf Weiter.

Wenn Sie strukturierte Daten einmalig importieren:

Felder Schlüsselattributen zuordnen

Wenn wichtige Felder im Schema fehlen, fügen Sie sie mit Neues Feld hinzufügen hinzu.

Weitere Informationen finden Sie unter Automatische Erkennung und Bearbeitung.

Klicken Sie auf Weiter.

Wählen Sie eine Region für den Datenspeicher aus.

Geben Sie einen Namen für den Datenspeicher ein.

Klicken Sie auf Erstellen.

Wenn Sie den Status der Aufnahme prüfen möchten, rufen Sie die Seite Datenspeicher auf und klicken Sie auf den Namen des Datenspeichers, um Details dazu auf der Seite Daten aufzurufen. Wenn sich die Statusspalte auf dem Tab Aktivität von Wird ausgeführt in Import abgeschlossen ändert, ist die Aufnahme abgeschlossen.

Je nach Größe der Daten kann die Datenaufnahme einige Minuten bis mehrere Stunden dauern.

REST

So erstellen Sie einen Datenspeicher über die Befehlszeile und importieren Daten aus BigQuery:

Datenspeicher erstellen.

curl -X POST \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ -H "X-Goog-User-Project: PROJECT_ID" \ "https://discoveryengine.googleapis.com/v1/projects/PROJECT_ID/locations/global/collections/default_collection/dataStores?dataStoreId=DATA_STORE_ID" \ -d '{ "displayName": "DATA_STORE_DISPLAY_NAME", "industryVertical": "GENERIC", "solutionTypes": ["SOLUTION_TYPE_SEARCH"] }'Ersetzen Sie Folgendes:

PROJECT_ID: die ID Ihres Google Cloud Projekts.DATA_STORE_ID: Die ID des Vertex AI Search-Datenspeichers, den Sie erstellen möchten. Diese ID darf nur Kleinbuchstaben, Ziffern, Unterstriche und Bindestriche enthalten.DATA_STORE_DISPLAY_NAME: Der Anzeigename des Vertex AI Search-Datenspeichers, den Sie erstellen möchten.

Optional: Wenn Sie unstrukturierte Daten hochladen und das Parsen von Dokumenten konfigurieren oder das Aufteilen von Dokumenten für RAG aktivieren möchten, geben Sie das

documentProcessingConfig-Objekt an und fügen Sie es in Ihre Anfrage zum Erstellen des Datenspeichers ein. Wenn Sie gescannte PDFs aufnehmen, empfiehlt es sich, einen OCR-Parser für PDFs zu konfigurieren. Informationen zum Konfigurieren von Parsing- oder Chunking-Optionen finden Sie unter Dokumente parsen und in Chunks aufteilen.Daten aus BigQuery importieren

Wenn Sie ein Schema definiert haben, achten Sie darauf, dass die Daten diesem Schema entsprechen.

curl -X POST \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://discoveryengine.googleapis.com/v1/projects/PROJECT_ID/locations/global/collections/default_collection/dataStores/DATA_STORE_ID/branches/0/documents:import" \ -d '{ "bigquerySource": { "projectId": "PROJECT_ID", "datasetId":"DATASET_ID", "tableId": "TABLE_ID", "dataSchema": "DATA_SCHEMA", "aclEnabled": "BOOLEAN" }, "reconciliationMode": "RECONCILIATION_MODE", "autoGenerateIds": "AUTO_GENERATE_IDS", "idField": "ID_FIELD", "errorConfig": { "gcsPrefix": "ERROR_DIRECTORY" } }'Ersetzen Sie Folgendes:

PROJECT_ID: die ID Ihres Google Cloud Projekts.DATA_STORE_ID: Die ID des Vertex AI Search-Datenspeichers.DATASET_ID: die ID des BigQuery-Datasets.TABLE_ID: Die ID der BigQuery-Tabelle.- Wenn sich die BigQuery-Tabelle nicht unter PROJECT_ID befindet, müssen Sie dem Dienstkonto

service-<project number>@gcp-sa-discoveryengine.iam.gserviceaccount.comdie Berechtigung „BigQuery Data Viewer“ für die BigQuery-Tabelle erteilen. Wenn Sie beispielsweise eine BigQuery-Tabelle aus dem Quellprojekt „123“ in das Zielprojekt „456“ importieren, erteilen Sie die Berechtigungen für die BigQuery-Tabelle im Projekt „123“ für[email protected].

- Wenn sich die BigQuery-Tabelle nicht unter PROJECT_ID befindet, müssen Sie dem Dienstkonto

DATA_SCHEMA: Optional. Mögliche Werte sinddocumentundcustom. Der Standardwert istdocument.document: Die BigQuery-Tabelle, die Sie verwenden, muss dem standardmäßigen BigQuery-Schema entsprechen, das unter Daten für die Aufnahme vorbereiten bereitgestellt wird. Sie können die ID jedes Dokuments selbst definieren, während Sie alle Daten in den jsonData-String einfügen.custom: Es wird jedes BigQuery-Tabellenschema akzeptiert und Vertex AI Search generiert automatisch die IDs für jedes importierte Dokument.

ERROR_DIRECTORY: Optional. Ein Cloud Storage-Verzeichnis für Fehlerinformationen zum Import, z. B.gs://<your-gcs-bucket>/directory/import_errors. Google empfiehlt, dieses Feld leer zu lassen, damit Vertex AI Search automatisch ein temporäres Verzeichnis erstellt.RECONCILIATION_MODE: Optional. Mögliche Werte sindFULLundINCREMENTAL. Der Standardwert istINCREMENTAL. Wenn SieINCREMENTALangeben, werden Daten aus BigQuery inkrementell in Ihrem Datenspeicher aktualisiert. Dadurch wird ein Upsert-Vorgang ausgeführt, bei dem neue Dokumente hinzugefügt und vorhandene Dokumente durch aktualisierte Dokumente mit derselben ID ersetzt werden. Wenn SieFULLangeben, werden die Dokumente in Ihrem Datenspeicher vollständig neu indexiert. Mit anderen Worten: Neue und aktualisierte Dokumente werden Ihrem Datenspeicher hinzugefügt und Dokumente, die nicht in BigQuery enthalten sind, werden aus Ihrem Datenspeicher entfernt. Der ModusFULList hilfreich, wenn Sie Dokumente, die Sie nicht mehr benötigen, automatisch löschen möchten.AUTO_GENERATE_IDS: Optional. Gibt an, ob Dokument-IDs automatisch generiert werden sollen. Wenn dieser Wert auftruegesetzt ist, werden Dokument-IDs auf Grundlage eines Hash der Nutzlast generiert. Beachten Sie, dass generierte Dokument-IDs bei mehreren Importvorgängen möglicherweise nicht konsistent bleiben. Wenn Sie IDs bei mehreren Importvorgängen automatisch generieren, empfiehlt Google dringend,reconciliationModeaufFULLzu setzen, um einheitliche Dokument-IDs zu erhalten.Geben Sie

autoGenerateIdsnur an, wennbigquerySource.dataSchemaaufcustomfestgelegt ist. Andernfalls wird der FehlerINVALID_ARGUMENTzurückgegeben. Wenn SieautoGenerateIdsnicht angeben oder auffalsefestlegen, müssen SieidFieldangeben. Andernfalls schlägt der Import der Dokumente fehl.ID_FIELD: Optional. Gibt an, welche Felder die Dokument-IDs sind. Bei BigQuery-Quelldateien gibtidFieldden Namen der Spalte in der BigQuery-Tabelle an, die die Dokument-IDs enthält.Geben Sie

idFieldnur an, wenn (1)bigquerySource.dataSchemaaufcustomfestgelegt ist und (2)auto_generate_idsauffalsefestgelegt oder nicht angegeben ist. Andernfalls wird der FehlerINVALID_ARGUMENTzurückgegeben.Der Wert des BigQuery-Spaltennamens muss vom Typ „String“ sein, zwischen 1 und 63 Zeichen lang sein und RFC-1034 entsprechen. Andernfalls schlägt der Import der Dokumente fehl.

C#

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications C# API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Go

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Go API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Java

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Java API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Node.js

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Node.js API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Python

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Python API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Ruby

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Ruby API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Mit BigQuery verbinden und Daten regelmäßig synchronisieren

Bevor Sie Ihre Daten importieren, lesen Sie den Artikel Daten für die Aufnahme vorbereiten.

In der folgenden Anleitung wird beschrieben, wie Sie einen Datenconnector erstellen, der ein BigQuery-Dataset mit einem Vertex AI Search-Datenconnector verknüpft, und wie Sie für jeden Datenspeicher, den Sie erstellen möchten, eine Tabelle im Dataset angeben. Datenspeicher, die untergeordnete Elemente von Datenconnectors sind, werden als Entitätsdatenspeicher bezeichnet.

Die Daten aus dem Dataset werden regelmäßig mit den Datenspeichern der Entitäten synchronisiert. Sie können die Synchronisierung täglich, alle drei Tage oder alle fünf Tage festlegen.

Console

So erstellen Sie mit der Google Cloud Console einen Connector, der Daten regelmäßig aus einem BigQuery-Dataset mit Vertex AI Search synchronisiert:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Klicken Sie im Navigationsmenü auf Datenspeicher.

Klicken Sie auf Datenspeicher erstellen.

Wählen Sie auf der Seite Quelle die Option BigQuery aus.

Wählen Sie den Typ der Daten aus, die Sie importieren.

Klicken Sie auf Regelmäßig.

Wählen Sie die Synchronisierungshäufigkeit aus, also wie oft der Vertex AI Search-Connector mit dem BigQuery-Dataset synchronisiert werden soll. Sie können die Häufigkeit später ändern.

Klicken Sie im Feld BigQuery-Datasetpfad auf Durchsuchen und wählen Sie das Dataset aus, das die Tabellen enthält, die Sie für den Import vorbereitet haben. Alternativ können Sie den Speicherort der Tabelle direkt in das Feld BigQuery-Pfad eingeben. Das Format für den Pfad ist

projectname.datasetname.Klicken Sie im Feld Zu synchronisierende Tabellen auf Durchsuchen und wählen Sie dann eine Tabelle mit den Daten aus, die Sie für Ihren Datenspeicher benötigen.

Wenn das Dataset weitere Tabellen enthält, die Sie für Datenspeicher verwenden möchten, klicken Sie auf Tabelle hinzufügen und geben Sie auch diese Tabellen an.

Klicken Sie auf Weiter.

Wählen Sie eine Region für den Datenspeicher aus, geben Sie einen Namen für den Datenconnector ein und klicken Sie auf Erstellen.

Sie haben jetzt einen Data Connector erstellt, der Daten regelmäßig mit dem BigQuery-Dataset synchronisiert. Außerdem haben Sie mindestens einen Entitätsdatenspeicher erstellt. Die Datenspeicher haben dieselben Namen wie die BigQuery-Tabellen.

Wenn Sie den Status der Aufnahme prüfen möchten, rufen Sie die Seite Datenspeicher auf und klicken Sie auf den Namen Ihres Datenconnectors. Auf der Seite Daten > Tab Aktivität bei der Datenaufnahme finden Sie dann Details dazu. Wenn sich die Statusspalte auf dem Tab Aktivität von Wird ausgeführt in Erfolgreich ändert, ist die erste Aufnahme abgeschlossen.

Je nach Größe der Daten kann die Datenaufnahme einige Minuten bis mehrere Stunden dauern.

Nachdem Sie Ihre Datenquelle eingerichtet und Daten zum ersten Mal importiert haben, werden Daten aus dieser Quelle in dem Intervall synchronisiert, das Sie bei der Einrichtung ausgewählt haben. Etwa eine Stunde nach dem Erstellen des Daten-Connectors erfolgt die erste Synchronisierung. Die nächste Synchronisierung erfolgt dann etwa 24, 72 oder 120 Stunden später.

Nächste Schritte

Wenn Sie Ihren Datenspeicher an eine App anhängen möchten, erstellen Sie eine App und wählen Sie Ihren Datenspeicher aus. Folgen Sie dazu der Anleitung unter Suchanwendung erstellen.

Eine Vorschau der Suchergebnisse nach der Einrichtung Ihrer App und Ihres Datenspeichers finden Sie unter Suchergebnisse abrufen.

Aus Cloud Storage importieren

Sie haben zwei Möglichkeiten, Datenspeicher aus Cloud Storage-Tabellen zu erstellen:

Einmalige Aufnahme: Sie importieren Daten aus einem Cloud Storage-Ordner oder einer Cloud Storage-Datei in einen Datenspeicher. Die Daten im Datenspeicher ändern sich nur, wenn Sie sie manuell aktualisieren.

Regelmäßige Aufnahme: Sie importieren Daten aus einem Cloud Storage-Ordner oder einer Cloud Storage-Datei und legen eine Synchronisierungshäufigkeit fest, die bestimmt, wie oft der Datenspeicher mit den neuesten Daten von diesem Cloud Storage-Speicherort aktualisiert wird.

In der folgenden Tabelle werden die beiden Möglichkeiten zum Importieren von Cloud Storage-Daten in Vertex AI Search-Datenspeicher verglichen.

| Einmalige Aufnahme | Regelmäßige Aufnahme |

|---|---|

| Allgemein verfügbar (GA) | Öffentliche Vorschau |

| Die Daten müssen manuell aktualisiert werden. | Die Daten werden automatisch alle ein, drei oder fünf Tage aktualisiert. Daten können nicht manuell aktualisiert werden. |

| Vertex AI Search erstellt einen einzelnen Datenspeicher aus einem Ordner oder einer Datei in Cloud Storage. | Vertex AI Search erstellt einen Datenconnector und verknüpft einen Datenspeicher (einen Entitätsdatenspeicher) damit für die angegebene Datei oder den angegebenen Ordner. Jeder Cloud Storage-Datenconnector kann einen einzelnen Entity-Datenspeicher haben. |

| Daten aus mehreren Dateien, Ordnern und Buckets können in einem Datenspeicher kombiniert werden, indem Sie zuerst Daten von einem Cloud Storage-Speicherort und dann weitere Daten von einem anderen Speicherort aufnehmen. | Da der manuelle Datenimport nicht unterstützt wird, können die Daten in einem Entity-Datenspeicher nur aus einer Cloud Storage-Datei oder einem Cloud Storage-Ordner stammen. |

| Die Zugriffssteuerung für Datenquellen wird unterstützt. Weitere Informationen finden Sie unter Zugriffssteuerung für Datenquellen. | Die Zugriffssteuerung für Datenquellen wird nicht unterstützt. Die importierten Daten können Zugriffssteuerungen enthalten, diese werden jedoch nicht berücksichtigt. |

| Sie können einen Datenspeicher entweder über dieGoogle Cloud Console oder die API erstellen. | Sie müssen die Console verwenden, um Daten-Connectors und die zugehörigen Datenspeicher für Entitäten zu erstellen. |

| CMEK-kompatibel. | CMEK-kompatibel. |

Einmaliger Import aus Cloud Storage

Wenn Sie Daten aus Cloud Storage aufnehmen möchten, gehen Sie so vor, um einen Datenspeicher zu erstellen und Daten entweder über die Google Cloud Console oder die API aufzunehmen.

Bevor Sie Ihre Daten importieren, lesen Sie den Artikel Daten für die Aufnahme vorbereiten.

Console

So nehmen Sie Daten aus einem Cloud Storage-Bucket über die Console auf:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Rufen Sie die Seite Datenspeicher auf.

Klicken Sie auf Datenspeicher erstellen.

Wählen Sie auf der Seite Quelle die Option Cloud Storage aus.

Wählen Sie im Bereich Ordner oder Datei für Import auswählen die Option Ordner oder Datei aus.

Klicken Sie auf Durchsuchen, wählen Sie die Daten aus, die Sie für die Aufnahme vorbereitet haben, und klicken Sie dann auf Auswählen. Alternativ können Sie den Standort direkt in das Feld

gs://eingeben.Wählen Sie aus, welche Art von Daten Sie importieren.

Klicken Sie auf Weiter.

Wenn Sie strukturierte Daten einmalig importieren:

Felder Schlüsselattributen zuordnen

Wenn wichtige Felder im Schema fehlen, fügen Sie sie mit Neues Feld hinzufügen hinzu.

Weitere Informationen finden Sie unter Automatische Erkennung und Bearbeitung.

Klicken Sie auf Weiter.

Wählen Sie eine Region für den Datenspeicher aus.

Geben Sie einen Namen für den Datenspeicher ein.

Optional: Wenn Sie unstrukturierte Dokumente ausgewählt haben, können Sie Parsing- und Chunking-Optionen für Ihre Dokumente auswählen. Informationen zum Vergleichen von Parsern finden Sie unter Dokumente parsen. Informationen zum Aufteilen von Dokumenten in Chunks finden Sie unter Dokumente für RAG in Chunks aufteilen.

Für den OCR-Parser und den Layout-Parser können zusätzliche Kosten anfallen. Preise für Document AI-Funktionen

Wenn Sie einen Parser auswählen möchten, maximieren Sie Optionen für die Dokumentverarbeitung und geben Sie die gewünschten Parseroptionen an.

Klicken Sie auf Erstellen.

Wenn Sie den Status der Aufnahme prüfen möchten, rufen Sie die Seite Datenspeicher auf und klicken Sie auf den Namen des Datenspeichers, um Details dazu auf der Seite Daten aufzurufen. Wenn sich die Statusspalte auf dem Tab Aktivität von Wird ausgeführt in Import abgeschlossen ändert, ist die Aufnahme abgeschlossen.

Je nach Größe der Daten kann die Datenaufnahme einige Minuten oder mehrere Stunden dauern.

REST

So erstellen Sie einen Datenspeicher und nehmen Daten aus Cloud Storage über die Befehlszeile auf:

Datenspeicher erstellen.

curl -X POST \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ -H "X-Goog-User-Project: PROJECT_ID" \ "https://discoveryengine.googleapis.com/v1/projects/PROJECT_ID/locations/global/collections/default_collection/dataStores?dataStoreId=DATA_STORE_ID" \ -d '{ "displayName": "DATA_STORE_DISPLAY_NAME", "industryVertical": "GENERIC", "solutionTypes": ["SOLUTION_TYPE_SEARCH"] }'Ersetzen Sie Folgendes:

PROJECT_ID: die ID Ihres Google Cloud Projekts.DATA_STORE_ID: Die ID des Vertex AI Search-Datenspeichers, den Sie erstellen möchten. Diese ID darf nur Kleinbuchstaben, Ziffern, Unterstriche und Bindestriche enthalten.DATA_STORE_DISPLAY_NAME: Der Anzeigename des Vertex AI Search-Datenspeichers, den Sie erstellen möchten.

Optional: Wenn Sie unstrukturierte Daten hochladen und das Parsen von Dokumenten konfigurieren oder das Aufteilen von Dokumenten für RAG aktivieren möchten, geben Sie das

documentProcessingConfig-Objekt an und fügen Sie es in Ihre Anfrage zum Erstellen des Datenspeichers ein. Wenn Sie gescannte PDFs aufnehmen, empfiehlt es sich, einen OCR-Parser für PDFs zu konfigurieren. Informationen zum Konfigurieren von Parsing- oder Chunking-Optionen finden Sie unter Dokumente parsen und in Chunks aufteilen.Daten aus Cloud Storage importieren.

curl -X POST \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://discoveryengine.googleapis.com/v1/projects/PROJECT_ID/locations/global/collections/default_collection/dataStores/DATA_STORE_ID/branches/0/documents:import" \ -d '{ "gcsSource": { "inputUris": ["INPUT_FILE_PATTERN_1", "INPUT_FILE_PATTERN_2"], "dataSchema": "DATA_SCHEMA", }, "reconciliationMode": "RECONCILIATION_MODE", "autoGenerateIds": "AUTO_GENERATE_IDS", "idField": "ID_FIELD", "errorConfig": { "gcsPrefix": "ERROR_DIRECTORY" } }'Ersetzen Sie Folgendes:

PROJECT_ID: die ID Ihres Google Cloud Projekts.DATA_STORE_ID: Die ID des Vertex AI Search-Datenspeichers.INPUT_FILE_PATTERN: Ein Dateimuster in Cloud Storage, das Ihre Dokumente enthält.Für strukturierte Daten oder unstrukturierte Daten mit Metadaten ist ein Beispiel für das Eingabedateimuster

gs://<your-gcs-bucket>/directory/object.jsonund ein Beispiel für ein Muster, das mit einer oder mehreren Dateien übereinstimmt,gs://<your-gcs-bucket>/directory/*.json.Ein Beispiel für unstrukturierte Dokumente ist

gs://<your-gcs-bucket>/directory/*.pdf. Jede Datei, die dem Muster entspricht, wird zu einem Dokument.Wenn

<your-gcs-bucket>nicht unter PROJECT_ID aufgeführt ist, müssen Sie dem Dienstkontoservice-<project number>@gcp-sa-discoveryengine.iam.gserviceaccount.comdie Berechtigungen „Storage-Objekt-Betrachter“ für den Cloud Storage-Bucket gewähren. Wenn Sie beispielsweise einen Cloud Storage-Bucket aus dem Quellprojekt „123“ in das Zielprojekt „456“ importieren, gewähren Sie[email protected]-Berechtigungen für den Cloud Storage-Bucket im Projekt „123“.DATA_SCHEMA: Optional. Die Werte sinddocument,custom,csvundcontent. Der Standardwert istdocument.document: Unstrukturierte Daten mit Metadaten für unstrukturierte Dokumente hochladen. Jede Zeile der Datei muss eines der folgenden Formate haben. Sie können die ID jedes Dokuments definieren:{ "id": "<your-id>", "jsonData": "<JSON string>", "content": { "mimeType": "<application/pdf or text/html>", "uri": "gs://<your-gcs-bucket>/directory/filename.pdf" } }{ "id": "<your-id>", "structData": <JSON object>, "content": { "mimeType": "<application/pdf or text/html>", "uri": "gs://<your-gcs-bucket>/directory/filename.pdf" } }

custom: JSON für strukturierte Dokumente hochladen. Die Daten sind nach einem Schema organisiert. Sie können das Schema angeben. Andernfalls wird es automatisch erkannt. Sie können den JSON-String des Dokuments in einem einheitlichen Format direkt in jede Zeile einfügen. Vertex AI Search generiert dann automatisch die IDs für jedes importierte Dokument.content: Unstrukturierte Dokumente (PDF, HTML, DOC, TXT, PPTX) hochladen Die ID jedes Dokuments wird automatisch als die ersten 128 Bit von SHA256(GCS_URI) generiert, die als Hexadezimalstring codiert sind. Sie können mehrere Eingabedateimuster angeben, solange die übereinstimmenden Dateien das Limit von 100.000 Dateien nicht überschreiten.csv: Fügen Sie Ihrer CSV-Datei eine Kopfzeile hinzu, in der jeder Header einem Dokumentfeld zugeordnet ist. Geben Sie den Pfad zur CSV-Datei mit dem FeldinputUrisan.

ERROR_DIRECTORY: Optional. Ein Cloud Storage-Verzeichnis für Fehlerinformationen zum Import, z. B.gs://<your-gcs-bucket>/directory/import_errors. Google empfiehlt, dieses Feld leer zu lassen, damit Vertex AI Search automatisch ein temporäres Verzeichnis erstellt.RECONCILIATION_MODE: Optional. Mögliche Werte sindFULLundINCREMENTAL. Der Standardwert istINCREMENTAL. Wenn SieINCREMENTALangeben, werden die Daten aus Cloud Storage in Ihrem Datenspeicher inkrementell aktualisiert. Dadurch wird ein Upsert-Vorgang ausgeführt, bei dem neue Dokumente hinzugefügt und vorhandene Dokumente durch aktualisierte Dokumente mit derselben ID ersetzt werden. Wenn SieFULLangeben, werden die Dokumente in Ihrem Datenspeicher vollständig neu indexiert. Das bedeutet, dass Ihrem Datenspeicher neue und aktualisierte Dokumente hinzugefügt werden und Dokumente, die nicht in Cloud Storage enthalten sind, aus Ihrem Datenspeicher entfernt werden. Der ModusFULList hilfreich, wenn Sie Dokumente, die Sie nicht mehr benötigen, automatisch löschen lassen möchten.AUTO_GENERATE_IDS: Optional. Gibt an, ob Dokument-IDs automatisch generiert werden sollen. Wenn dieser Wert auftruegesetzt ist, werden Dokument-IDs auf Grundlage eines Hash der Nutzlast generiert. Beachten Sie, dass generierte Dokument-IDs bei mehreren Importvorgängen möglicherweise nicht konsistent bleiben. Wenn Sie IDs bei mehreren Importvorgängen automatisch generieren, empfiehlt Google dringend,reconciliationModeaufFULLzu setzen, um einheitliche Dokument-IDs beizubehalten.Geben Sie

autoGenerateIdsnur an, wenngcsSource.dataSchemaaufcustomodercsvfestgelegt ist. Andernfalls wird der FehlerINVALID_ARGUMENTzurückgegeben. Wenn SieautoGenerateIdsnicht angeben oder auffalsefestlegen, müssen SieidFieldangeben. Andernfalls können die Dokumente nicht importiert werden.ID_FIELD: Optional. Gibt an, welche Felder die Dokument-IDs sind. Bei Cloud Storage-Quelldokumenten gibtidFieldden Namen in den JSON-Feldern an, die Dokument-IDs sind. Wenn{"my_id":"some_uuid"}beispielsweise das Feld für die Dokument-ID in einem Ihrer Dokumente ist, geben Sie"idField":"my_id"an. Dadurch werden alle JSON-Felder mit dem Namen"my_id"als Dokument-IDs identifiziert.Geben Sie dieses Feld nur an, wenn (1)

gcsSource.dataSchemaaufcustomodercsvfestgelegt ist und (2)auto_generate_idsauffalsefestgelegt oder nicht angegeben ist. Andernfalls wird der FehlerINVALID_ARGUMENTzurückgegeben.Der Wert des Cloud Storage-JSON-Felds muss vom Typ „string“ sein, zwischen 1 und 63 Zeichen lang sein und RFC-1034 entsprechen. Andernfalls können die Dokumente nicht importiert werden.

Der von

id_fieldangegebene JSON-Feldname muss vom Typ „String“ sein, zwischen 1 und 63 Zeichen lang sein und RFC-1034 entsprechen. Andernfalls können die Dokumente nicht importiert werden.

C#

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications C# API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Go

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Go API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Java

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Java API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Node.js

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Node.js API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Python

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Python API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Ruby

Weitere Informationen finden Sie in der Referenzdokumentation zur AI Applications Ruby API.

Richten Sie zur Authentifizierung bei AI Applications Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Datenspeicher erstellen

Dokumente importieren

Mit Cloud Storage verbinden und regelmäßig synchronisieren

Bevor Sie Ihre Daten importieren, lesen Sie den Artikel Daten für die Aufnahme vorbereiten.

In der folgenden Anleitung wird beschrieben, wie Sie einen Daten-Connector erstellen, der einen Cloud Storage-Speicherort mit einem Vertex AI Search-Daten-Connector verknüpft, und wie Sie einen Ordner oder eine Datei an diesem Speicherort für den Datenspeicher angeben, den Sie erstellen möchten. Datenspeicher, die untergeordnete Elemente von Daten-Connectors sind, werden als Entitätsdatenspeicher bezeichnet.

Die Daten werden regelmäßig mit dem Entitätendatenspeicher synchronisiert. Sie können die Synchronisierung täglich, alle drei Tage oder alle fünf Tage festlegen.

Console

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Rufen Sie die Seite Datenspeicher auf.

Klicken Sie auf Datenspeicher erstellen.

Wählen Sie auf der Seite Quelle die Option Cloud Storage aus.

Wählen Sie aus, welche Art von Daten Sie importieren.

Klicken Sie auf Regelmäßig.

Wählen Sie die Häufigkeit der Synchronisierung aus, um festzulegen, wie oft der Vertex AI Search-Connector mit dem Cloud Storage-Speicherort synchronisiert werden soll. Sie können die Häufigkeit später ändern.

Wählen Sie im Bereich Ordner oder Datei für Import auswählen die Option Ordner oder Datei aus.

Klicken Sie auf Durchsuchen, wählen Sie die Daten aus, die Sie für die Aufnahme vorbereitet haben, und klicken Sie dann auf Auswählen. Alternativ können Sie den Standort direkt in das Feld

gs://eingeben.Klicken Sie auf Weiter.

Wählen Sie eine Region für Ihren Daten-Connector aus.

Geben Sie einen Namen für den Daten-Connector ein.

Optional: Wenn Sie unstrukturierte Dokumente ausgewählt haben, können Sie Parsing- und Chunking-Optionen für Ihre Dokumente auswählen. Informationen zum Vergleichen von Parsern finden Sie unter Dokumente parsen. Informationen zum Aufteilen von Dokumenten in Chunks finden Sie unter Dokumente für RAG in Chunks aufteilen.

Für den OCR-Parser und den Layout-Parser können zusätzliche Kosten anfallen. Preise für Document AI-Funktionen

Wenn Sie einen Parser auswählen möchten, maximieren Sie Optionen für die Dokumentverarbeitung und geben Sie die gewünschten Parseroptionen an.

Klicken Sie auf Erstellen.

Sie haben jetzt einen Datenconnector erstellt, der Daten regelmäßig mit dem Cloud Storage-Speicherort synchronisiert. Sie haben auch einen Entitätendatenspeicher mit dem Namen

gcs_storeerstellt.Wenn Sie den Status der Aufnahme prüfen möchten, rufen Sie die Seite Datenspeicher auf und klicken Sie auf den Namen des Datenconnectors, um Details dazu auf der Seite Daten aufzurufen.

Tab Datenaufnahmeaktivität Wenn sich die Statusspalte auf dem Tab Aktivität zur Datenerfassung von Wird ausgeführt in Erfolgreich ändert, ist die erste Erfassung abgeschlossen.

Je nach Größe der Daten kann die Datenaufnahme einige Minuten bis mehrere Stunden dauern.

Nachdem Sie Ihre Datenquelle eingerichtet und Daten zum ersten Mal importiert haben, werden Daten aus dieser Quelle in einem Intervall synchronisiert, das Sie bei der Einrichtung auswählen. Etwa eine Stunde nach dem Erstellen des Daten-Connectors erfolgt die erste Synchronisierung. Die nächste Synchronisierung erfolgt dann etwa 24, 72 oder 120 Stunden später.

Nächste Schritte

Wenn Sie Ihren Datenspeicher an eine App anhängen möchten, erstellen Sie eine App und wählen Sie Ihren Datenspeicher aus. Folgen Sie dazu der Anleitung unter Suchanwendung erstellen.

Eine Vorschau der Suchergebnisse nach der Einrichtung Ihrer App und Ihres Datenspeichers finden Sie unter Suchergebnisse abrufen.

Verbindung zu Google Drive herstellen

Wenn Sie Daten aus Google Drive durchsuchen möchten, verwenden Sie eine der folgenden Methoden, um einen Connector über die Google Cloud -Konsole zu erstellen:

- Datenföderation verwenden: Die erforderlichen Informationen werden direkt aus der angegebenen Datenquelle abgerufen. Daten werden nicht in den Vertex AI Search-Index kopiert.

- Datenindexierung verwenden: Kopiert Daten in den Vertex AI Search-Index. Dadurch erhalten Sie bessere Suchergebnisse. Der Connector ist cloudnativ, da er Daten kopiert, ähnlich wie bei der Option Erweiterte Drive-Indexierung verwenden.

Hinweise

- Sie müssen in der Google Cloud Konsole mit demselben Konto angemeldet sein, das Sie für die Google Drive-Instanz verwenden, die Sie verbinden möchten. AI Applications verwendet Ihre Google Workspace-Kunden-ID, um eine Verbindung zu Google Drive herzustellen.

- Legen Sie den Identitätsanbieter fest, mit dem sich Nutzer in der App anmelden sollen. Wenn Sie einen Drittanbieter-Identitätsanbieter verwenden, muss ein Administrator Ihren Identitätsanbieter mit Google Workspace verbinden. Die Föderation erfordert Planung und Einrichtung. Weitere Informationen finden Sie unter Zugriffssteuerung für Datenquellen verwenden.

- Die erweiterte Google Drive-Suche ist als nicht öffentliche Vorschau verfügbar. Diese Funktion ist eine Voraussetzung für die Verwendung der Zusammenfassung von Suchergebnissen und der Suche mit weiterführenden Fragen mit einem Google Drive-Datenspeicher. Wenn Sie diese Funktion verwenden möchten, folgen Sie stattdessen der Anleitung unter Erweiterte Drive-Indexierung verwenden.

Wenn Sie Sicherheitskontrollen verwenden, beachten Sie die Einschränkungen in Bezug auf Daten in Google Drive, die in der folgenden Tabelle beschrieben werden:

Sicherheitskontrollen Wichtige Hinweise Datenstandort (DRZ) AI Applications garantiert die Datenspeicherung nur in Google Cloud. Informationen zum Datenstandort und zu Google Drive finden Sie in den Compliance-Leitfäden und der Dokumentation zu Google Workspace, z. B. unter Region für die Datenspeicherung auswählen und Digitale Souveränität. Vom Kunden verwaltete Verschlüsselungsschlüssel (CMEK) Ihre Schlüssel verschlüsseln nur Daten in Google Cloud. Die Steuerelemente von Cloud Key Management Service gelten nicht für in Google Drive gespeicherte Daten. Access Transparency In Access Transparency-Logs werden Aktionen aufgezeichnet, die von Google-Mitarbeitern im Google Cloud -Projekt ausgeführt wurden. Sie müssen auch die von Google Workspace erstellten Access Transparency-Logs prüfen. Weitere Informationen finden Sie in der Google Workspace-Admin-Hilfe unter Access Transparency-Logereignisse.

Data Federation verwenden

Wenn Sie einen Datenspeicher erstellen, ohne die erweiterte Indexierung zu aktivieren, greift das System direkt auf die Inhalte des angegebenen Laufwerks zu und zeigt sie an, ohne eine Kopie zu erstellen.

Console

So machen Sie Google Drive-Daten über die Console durchsuchbar:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Klicken Sie im Navigationsmenü auf Datenspeicher.

Klicken Sie auf Datenspeicher erstellen.

Neuen Datenspeicher erstellen Wählen Sie auf der Seite Datenquelle auswählen die Option Google Drive aus.

Wählen Sie eine Datenquelle aus. Geben Sie die Drive-Quelle für Ihren Datenspeicher an.

- Alle: Wenn Sie Ihren gesamten Drive-Speicher dem Datenspeicher hinzufügen möchten.

- Bestimmte geteilte Ablage(n): Hiermit fügen Sie eine oder mehrere geteilte Ablagen hinzu.

Fügen Sie die IDs der geteilten Ablagen hinzu. Wenn Sie die ID der geteilten Ablage herausfinden möchten, rufen Sie die geteilte Ablage auf und kopieren Sie die ID aus der URL. Die URL hat folgendes Format:

https://drive.google.com/corp/drive/DRIVE_ID.Bestimmte(r) freigegebene(r) Ordner: Hier können Sie einen oder mehrere freigegebene Ordner hinzufügen.

- Fügen Sie die IDs der freigegebenen Ordner hinzu. Wenn Sie die ID des freigegebenen Ordners herausfinden möchten, rufen Sie den freigegebenen Ordner auf und kopieren Sie die ID aus der URL. Die URL hat das folgende Format:

https://drive.google.com/corp/drive/folders/FOLDER_ID.

- Fügen Sie die IDs der freigegebenen Ordner hinzu. Wenn Sie die ID des freigegebenen Ordners herausfinden möchten, rufen Sie den freigegebenen Ordner auf und kopieren Sie die ID aus der URL. Die URL hat das folgende Format:

Drive-Quelle angeben Klicken Sie auf Weiter.

Wählen Sie eine Region für den Datenspeicher aus.

Geben Sie einen Namen für den Datenspeicher ein.

Klicken Sie auf Erstellen.

Daten-Connector konfigurieren

Fehlermeldungen

In der folgenden Tabelle werden Fehlermeldungen beschrieben, die beim Arbeiten mit dieser Google-Datenquelle auftreten können. Sie enthält HTTP-Fehlercodes und Vorschläge zur Fehlerbehebung.

| Fehlercode | Fehlermeldung | Beschreibung | Fehlerbehebung |

|---|---|---|---|

| 400 (Vorbedingung nicht erfüllt) | Die Suche mit Dienstkontoanmeldedaten wird für Google Workspace-Datenspeicher nicht unterstützt. | Die durchsuchte Engine hat Google Workspace-Datenspeicher und die übergebenen Anmeldedaten gehören zu einem Dienstkonto. Die Suche in Google Workspace-Datenspeichern mit Anmeldedaten für Dienstkonten wird nicht unterstützt. | Rufen Sie die Suche mit Nutzeranmeldedaten auf oder entfernen Sie Google Workspace-Datenspeicher aus der Engine. |

| 400 (Vorbedingung nicht erfüllt) | Private Konten werden für Google Workspace-Datenspeicher nicht unterstützt. | Die Suche wird mit Anmeldedaten eines privaten Kontos (@gmail.com) aufgerufen, was für Google Workspace-Datenspeicher nicht unterstützt wird. | Entfernen Sie Google Workspace-Datenspeicher aus der Engine oder verwenden Sie ein verwaltetes Google-Konto. |

Datenindexierung verwenden (Private Vorschau)

Führen Sie diese Schritte aus, wenn Sie Google Drive mit der Zusammenfassung von Suchergebnissen und der Suche mit Follow-ups verwenden möchten.

Hinweise

- Sie müssen ein Google Workspace-Super Admin sein, um die erweiterte Drive-Indexierung zu aktivieren. Das liegt daran, dass bei der erweiterten Indexierung von Laufwerken KI-Anwendungen Google Drive-Daten indexieren.

Console

So erstellen Sie mit der Konsole einen Google Drive-Datenspeicher mit erweiterter Google Drive-Indexierung:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Klicken Sie im Navigationsmenü auf Datenspeicher.

Klicken Sie auf Datenspeicher erstellen.

Wählen Sie auf der Seite Datenquelle auswählen die Option Google Drive aus.

Wählen Sie Erweiterte Indexierung von Laufwerken aus.

Geben Sie die E-Mail-Adresse Ihres Google Workspace-Super Admin ein.

- Notieren Sie sich die Client-ID im Abschnitt Domainweite Delegierung einrichten im dritten Schritt, da sie später benötigt wird.

Laufwerkquelle für die erweiterte Indexierung angeben Domainweite Delegierung einrichten:

- Rufen Sie die Seite Domainweite Delegation in der Admin-Konsole von Google Workspace auf und melden Sie sich mit Ihrem Super-Admin-Konto an.

Klicken Sie auf Neu hinzufügen.

Neue domainweite Delegierung hinzufügen Geben Sie die Client-ID ein, die Sie zuvor notiert haben.

Geben Sie die folgenden OAuth-Bereiche ein.

https://www.googleapis.com/auth/drive.readonly, https://www.googleapis.com/auth/admin.directory.user.readonly, https://www.googleapis.com/auth/admin.directory.group.readonly, https://www.googleapis.com/auth/admin.directory.domain.readonly, https://www.googleapis.com/auth/admin.reports.audit.readonly

Geben Sie die OAuth-Bereiche ein. Klicken Sie auf Autorisieren.

Kehren Sie zur Google Cloud -Konsole zurück. Geben Sie im Abschnitt Zu synchronisierende Laufwerke auswählen die Drive-Quelle für Ihren Datenspeicher an.

- Alle: Wenn Sie Ihren gesamten Drive-Speicher dem Datenspeicher hinzufügen möchten.

Bestimmte geteilte Ablage(n): Hiermit fügen Sie eine oder mehrere geteilte Ablagen hinzu.

- Fügen Sie die IDs der geteilten Ablagen hinzu. Um die ID der geteilten Ablage zu finden, rufen Sie die geteilte Ablage auf und kopieren Sie die ID aus der URL. Die URL hat folgendes Format:

https://drive.google.com/corp/drive/DRIVE_ID.

Ablagen auswählen, die synchronisiert werden sollen - Fügen Sie die IDs der geteilten Ablagen hinzu. Um die ID der geteilten Ablage zu finden, rufen Sie die geteilte Ablage auf und kopieren Sie die ID aus der URL. Die URL hat folgendes Format:

Klicken Sie auf Weiter.

Wählen Sie eine Region für den Datenspeicher aus.

Geben Sie einen Namen für den Datenspeicher ein.

Optional: Wenn Sie die Konfigurationen für das Parsen oder Aufteilen von Dokumenten ändern möchten, wählen Sie im Bereich Optionen für die Dokumentverarbeitung die Option Konfiguration der Dokumentverarbeitung aktivieren aus.

Klicken Sie auf Erstellen. Je nach Größe der Daten kann die Datenaufnahme einige Minuten bis mehrere Stunden dauern. Warten Sie mindestens eine Stunde, bevor Sie Ihren Datenspeicher für die Suche verwenden.

Nächste Schritte

Wenn Sie Ihren Datenspeicher an eine App anhängen möchten, erstellen Sie eine App und wählen Sie Ihren Datenspeicher aus. Folgen Sie dazu der Anleitung unter Suchanwendung erstellen.

Informationen dazu, wie Sie Suchergebnisse erhalten, nachdem Ihre App und Ihr Datenspeicher eingerichtet wurden, finden Sie unter Suchergebnisse abrufen.

Mit Gmail verknüpfen

Wenn Sie Daten aus Gmail durchsuchen möchten, gehen Sie so vor, um einen Datenspeicher zu erstellen und Daten mit der Google Cloud Console aufzunehmen.

Hinweise:

Sie müssen in der Google Cloud Konsole mit demselben Konto angemeldet sein, das Sie für die Google Workspace-Instanz verwenden, die Sie verbinden möchten. Für die Verbindung zu Gmail wird die Google Workspace-Kunden-ID verwendet.

Zugriffssteuerung für Gmail einrichten Informationen zum Einrichten der Zugriffssteuerung finden Sie unter Zugriffssteuerung für Datenquellen verwenden.

Wenn Sie Sicherheitskontrollen verwenden, beachten Sie die Einschränkungen in Bezug auf Daten in Gmail, die in der folgenden Tabelle beschrieben werden:

Sicherheitskontrollen Wichtige Hinweise Datenstandort (DRZ) AI Applications garantiert die Datenspeicherung nur in Google Cloud. Informationen zum Datenstandort und zu Gmail finden Sie in den Compliance-Leitfäden und der Dokumentation zu Google Workspace, z. B. unter Region für die Datenspeicherung auswählen und Digitale Souveränität. Vom Kunden verwaltete Verschlüsselungsschlüssel (CMEK) Ihre Schlüssel verschlüsseln nur Daten in Google Cloud. Cloud Key Management Service-Steuerelemente gelten nicht für in Gmail gespeicherte Daten. Access Transparency In Access Transparency-Logs werden Aktionen aufgezeichnet, die von Google-Mitarbeitern im Google Cloud -Projekt ausgeführt wurden. Sie müssen auch die von Google Workspace erstellten Access Transparency-Logs prüfen. Weitere Informationen finden Sie in der Google Workspace-Admin-Hilfe unter Access Transparency-Logereignisse.

Console

So machen Sie Gmail-Daten mit der Console durchsuchbar:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Klicken Sie im Navigationsmenü auf Datenspeicher.

Klicken Sie auf Datenspeicher erstellen.

Neuen Datenspeicher erstellen. Wählen Sie auf der Seite Datenquelle auswählen die Option Google Gmail aus.

Wählen Sie die Google Gmail-Quelle aus. Wählen Sie eine Region für den Datenspeicher aus.

Geben Sie einen Namen für den Datenspeicher ein.

Klicken Sie auf Erstellen.

Konfigurieren Sie den neuen Connector.

Nächste Schritte

Wenn Sie Ihren Datenspeicher an eine App anhängen möchten, erstellen Sie eine App und wählen Sie Ihren Datenspeicher aus. Folgen Sie dazu der Anleitung unter Suchanwendung erstellen.

Unter Suchergebnisse abrufen finden Sie eine Vorschau der Suchergebnisse, nachdem Ihre App und Ihr Datenspeicher eingerichtet wurden.

Mit Google Sites verbinden

Wenn Sie Daten aus Google Sites durchsuchen möchten, gehen Sie so vor, um mit der Google Cloud Console einen Connector zu erstellen.

Hinweise:

Sie müssen in der Google Cloud Konsole mit demselben Konto angemeldet sein, das Sie für die Google Workspace-Instanz verwenden, die Sie verbinden möchten. Vertex AI Search verwendet Ihre Google Workspace-Kundennummer, um eine Verbindung zu Google Sites herzustellen.

Zugriffssteuerung für Google Sites einrichten Informationen zum Einrichten der Zugriffssteuerung finden Sie unter Zugriffssteuerung für Datenquellen verwenden.

Wenn Sie Sicherheitskontrollen verwenden, beachten Sie die Einschränkungen in Bezug auf Daten in Google Sites, die in der folgenden Tabelle beschrieben werden:

Sicherheitskontrollen Wichtige Hinweise Datenstandort (DRZ) AI Applications garantiert die Datenspeicherung nur in Google Cloud. Informationen zum Datenstandort und zu Google Sites finden Sie in den Compliance-Leitfäden und der Dokumentation zu Google Workspace, z. B. unter Region für die Datenspeicherung auswählen und Digitale Souveränität. Vom Kunden verwaltete Verschlüsselungsschlüssel (CMEK) Ihre Schlüssel verschlüsseln nur Daten in Google Cloud. Die Steuerelemente von Cloud Key Management Service gelten nicht für Daten, die in Google Sites gespeichert sind. Access Transparency In Access Transparency-Logs werden Aktionen aufgezeichnet, die von Google-Mitarbeitern im Google Cloud -Projekt ausgeführt wurden. Sie müssen auch die von Google Workspace erstellten Access Transparency-Logs prüfen. Weitere Informationen finden Sie in der Google Workspace-Admin-Hilfe unter Access Transparency-Logereignisse.

Console

So machen Sie Google Sites-Daten über die Console durchsuchbar:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Rufen Sie die Seite Datenspeicher auf.

Klicken Sie auf Neuer Datenspeicher.

Wählen Sie auf der Seite Quelle die Option Google Sites aus.

Wählen Sie eine Region für den Datenspeicher aus.

Geben Sie einen Namen für den Datenspeicher ein.

Klicken Sie auf Erstellen.

Nächste Schritte

Wenn Sie Ihren Datenspeicher an eine App anhängen möchten, erstellen Sie eine App und wählen Sie Ihren Datenspeicher aus. Folgen Sie dazu der Anleitung unter Suchanwendung erstellen.

Eine Vorschau der Suchergebnisse nach der Einrichtung Ihrer App und Ihres Datenspeichers finden Sie unter Suchergebnisse abrufen.

Mit Google Kalender verbinden

Wenn Sie Daten aus Google Kalender durchsuchen möchten, gehen Sie so vor, um einen Connector mit der Google Cloud Console zu erstellen.

Hinweise

Sie müssen in der Google Cloud Konsole mit demselben Konto angemeldet sein, das Sie für die Google Workspace-Instanz verwenden, die Sie verbinden möchten. Vertex AI Search verwendet Ihre Google Workspace-Kundennummer, um eine Verbindung zu Google Kalender herzustellen.

Zugriffssteuerung für Google Kalender einrichten Weitere Informationen finden Sie unter Zugriffssteuerung für Datenquellen verwenden.

Wenn Sie Sicherheitskontrollen verwenden, beachten Sie die Einschränkungen in Bezug auf Daten in Google Kalender, die in der folgenden Tabelle beschrieben werden:

Sicherheitskontrollen Wichtige Hinweise Datenstandort (DRZ) AI Applications garantiert die Datenspeicherung nur in Google Cloud. Informationen zum Datenstandort und zu Google Kalender finden Sie in den Google Workspace-Compliance-Leitfäden und der Dokumentation, z. B. unter Region für die Datenspeicherung auswählen und Digitale Souveränität. Vom Kunden verwaltete Verschlüsselungsschlüssel (CMEK) Ihre Schlüssel verschlüsseln nur Daten in Google Cloud. Cloud Key Management Service-Steuerelemente gelten nicht für Daten, die in Google Kalender gespeichert sind. Access Transparency In Access Transparency-Logs werden Aktionen aufgezeichnet, die von Google-Mitarbeitern im Google Cloud -Projekt ausgeführt wurden. Sie müssen auch die von Google Workspace erstellten Access Transparency-Logs prüfen. Weitere Informationen finden Sie in der Google Workspace-Admin-Hilfe unter Access Transparency-Logereignisse.

Console

So machen Sie Google Kalender-Daten mit der Console durchsuchbar:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Klicken Sie im Navigationsmenü auf Datenspeicher.

Klicken Sie auf Datenspeicher erstellen.

Neuen Datenspeicher erstellen Wählen Sie auf der Seite Datenquelle auswählen die Option Google Kalender aus.

Wählen Sie die Datenquelle „Google Kalender“ aus. Wählen Sie eine Region für den Datenspeicher aus.

Geben Sie einen Namen für den Datenspeicher ein.

Klicken Sie auf Erstellen.

Daten-Connector konfigurieren

Nächste Schritte

Wenn Sie Ihren Datenspeicher mit einer App verbinden möchten, erstellen Sie die App und wählen Sie dann den Datenspeicher aus. Folgen Sie dazu der Anleitung unter Such-App erstellen.

Informationen dazu, wie Sie Suchergebnisse erhalten, nachdem Ihre App und Ihr Datenspeicher eingerichtet wurden, finden Sie unter Suchergebnisse abrufen.

Fehlermeldungen

In der folgenden Tabelle werden Fehlermeldungen beschrieben, die beim Arbeiten mit dieser Google-Datenquelle auftreten können. Sie enthält HTTP-Fehlercodes und Vorschläge zur Fehlerbehebung.

| Fehlercode | Fehlermeldung | Beschreibung | Fehlerbehebung |

|---|---|---|---|

| 400 (Vorbedingung nicht erfüllt) | Die Suche mit Dienstkontoanmeldedaten wird für Google Workspace-Datenspeicher nicht unterstützt. | Die durchsuchte Engine hat Google Workspace-Datenspeicher und die übergebenen Anmeldedaten gehören zu einem Dienstkonto. Die Suche in Google Workspace-Datenspeichern mit Anmeldedaten für Dienstkonten wird nicht unterstützt. | Rufen Sie die Suche mit Nutzeranmeldedaten auf oder entfernen Sie Google Workspace-Datenspeicher aus der Engine. |

| 400 (Vorbedingung nicht erfüllt) | Private Konten werden für Google Workspace-Datenspeicher nicht unterstützt. | Die Suche wird mit Anmeldedaten eines privaten Kontos (@gmail.com) aufgerufen, was für Google Workspace-Datenspeicher nicht unterstützt wird. | Entfernen Sie Google Workspace-Datenspeicher aus der Engine oder verwenden Sie ein verwaltetes Google-Konto. |

Mit Google Groups verbinden

Wenn Sie Daten aus Google Groups durchsuchen möchten, gehen Sie so vor, um einen Connector mit der Google Cloud Console zu erstellen.

Hinweise:

Sie müssen in der Google Cloud Konsole mit demselben Konto angemeldet sein, das Sie für die Google Workspace-Instanz verwenden, die Sie verbinden möchten. Vertex AI Search verwendet Ihre Google Workspace-Kundennummer, um eine Verbindung zu Google-Gruppen herzustellen.

Zugriffssteuerung für Google Groups einrichten Informationen zum Einrichten der Zugriffssteuerung finden Sie unter Zugriffssteuerung für Datenquellen verwenden.

Wenn Sie Sicherheitskontrollen verwenden, beachten Sie die Einschränkungen in Bezug auf Daten in Google Groups, die in der folgenden Tabelle beschrieben werden:

Sicherheitskontrollen Wichtige Hinweise Datenstandort (DRZ) AI Applications garantiert die Datenspeicherung nur in Google Cloud. Informationen zum Datenstandort und zu Google Groups finden Sie in den Compliance-Leitfäden und der Dokumentation zu Google Workspace, z. B. unter Region für die Datenspeicherung auswählen und Digitale Souveränität. Vom Kunden verwaltete Verschlüsselungsschlüssel (CMEK) Ihre Schlüssel verschlüsseln nur Daten in Google Cloud. Die Steuerelemente des Cloud Key Management Service gelten nicht für Daten, die in Google Groups gespeichert sind. Access Transparency In Access Transparency-Logs werden Aktionen aufgezeichnet, die von Google-Mitarbeitern im Google Cloud -Projekt ausgeführt wurden. Sie müssen auch die von Google Workspace erstellten Access Transparency-Logs prüfen. Weitere Informationen finden Sie in der Google Workspace-Admin-Hilfe unter Access Transparency-Logereignisse.

Console

So machen Sie Google-Gruppen-Daten über die Console durchsuchbar:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Rufen Sie die Seite Datenspeicher auf.

Klicken Sie auf Neuer Datenspeicher.

Wählen Sie auf der Seite Quelle die Option Google-Gruppen aus.

Wählen Sie eine Region für den Datenspeicher aus.

Geben Sie einen Namen für den Datenspeicher ein.

Klicken Sie auf Erstellen. Je nach Größe der Daten kann die Datenaufnahme einige Minuten bis mehrere Stunden dauern. Warten Sie mindestens eine Stunde, bevor Sie Ihren Datenspeicher für die Suche verwenden.

Nächste Schritte

Wenn Sie Ihren Datenspeicher an eine App anhängen möchten, erstellen Sie eine App und wählen Sie Ihren Datenspeicher aus. Folgen Sie dazu der Anleitung unter Suchanwendung erstellen.

Eine Vorschau der Suchergebnisse nach der Einrichtung Ihrer App und Ihres Datenspeichers finden Sie unter Suchergebnisse abrufen.

Personendaten aus Google Workspace synchronisieren

Sie können die Personensuche für Ihre Organisation einrichten, indem Sie Personendaten aus Google Workspace synchronisieren. Nachdem der Datenspeicher für die Personensuche konfiguriert und Daten in den Vertex AI Search-Index aufgenommen wurden, können Sie Personen in Ihrem Verzeichnis finden.

Hinweise

- Legen Sie den Identitätsanbieter fest, mit dem sich Nutzer in der App anmelden sollen. Wenn Sie einen Drittanbieter-Identitätsanbieter verwenden, muss ein Administrator Ihren Identitätsanbieter mit Google Workspace verbinden. Die Föderation erfordert Planung und Einrichtung. Weitere Informationen finden Sie unter Zugriffssteuerung für Datenquellen verwenden.

Ein Google Workspace-Administrator muss die Personensuche für Google Workspace-Daten aktivieren:

- Melden Sie sich mit einem Administratorkonto in der Google Admin-Konsole an.

- Rufen Sie Verzeichnis > Verzeichniseinstellungen auf.

- Aktivieren Sie die Kontaktfreigabe.

Melden Sie sich in der Google Cloud -Konsole mit demselben Konto an, mit dem Sie Google Workspace verbinden möchten.

Stellen Sie eine Verbindung zu Ihrem Identitätsanbieter her, indem Sie die Schritte unter Verbindung zu Ihrem Identitätsanbieter herstellen ausführen, und geben Sie Google-Identität als Anbieter an. Informationen zum Google Workspace-Verzeichnis finden Sie in der Google Workspace-Dokumentation unter Übersicht: Verzeichnis einrichten und verwalten.

Wenn Sie Sicherheitskontrollen verwenden, beachten Sie die Einschränkungen in Bezug auf Daten in Google Workspace, die in der folgenden Tabelle beschrieben werden:

Sicherheitskontrollen Wichtige Hinweise Datenstandort (DRZ) AI Applications garantiert die Datenspeicherung nur in Google Cloud. Informationen zum Datenstandort und zu Google Workspace finden Sie in den Google Workspace-Compliance-Leitfäden und der zugehörigen Dokumentation, z. B. unter Region für die Datenspeicherung auswählen und Digitale Datenhoheit. Vom Kunden verwaltete Verschlüsselungsschlüssel (CMEK) Ihre Schlüssel verschlüsseln nur Daten in Google Cloud. Die Steuerelemente von Cloud Key Management Service gelten nicht für Daten, die in Google Workspace gespeichert sind. Access Transparency In Access Transparency-Logs werden Aktionen aufgezeichnet, die von Google-Mitarbeitern im Google Cloud -Projekt ausgeführt wurden. Sie müssen auch die von Google Workspace erstellten Access Transparency-Logs prüfen. Weitere Informationen finden Sie in der Google Workspace-Admin-Hilfe unter Access Transparency-Logereignisse.

Bevor Sie den Personendatenspeicher erstellen, müssen Sie ein Dienstkonto und eine domainweite Delegierung einrichten.

Dienstkonto einrichten

Erstellen Sie ein Dienstkonto in einemGoogle Cloud -Projekt innerhalb der Organisation.

Optional: Überspringen Sie den Schritt Diesem Dienstkonto Zugriff auf das Projekt gewähren (optional).

Überspringen Sie den Schritt „Diesem Dienstkonto Zugriff auf das Projekt erteilen (optional)“. Gewähren Sie dem Discovery Engine-Dienstkonto (

service-PROJECT_NUMBER@gcp-sa-discoveryengine.iam.gserviceaccount.com) Zugriff als Ersteller von Dienstkonto-Tokens (roles/iam.serviceAccountTokenCreator) und klicken Sie auf Speichern.

Gewähren Sie dem Discovery Engine-Dienstkonto Zugriff. Klicken Sie nach dem Erstellen des Dienstkontos auf den Tab Details des Dienstkontos und dann auf Erweiterte Einstellungen.

Kopieren Sie die Client-ID für die domainweite Delegierung.

Kopieren Sie die Client-ID.

Domainweite Delegierung einrichten

- Melden Sie sich im Google-Arbeitsbereich für Administratoren an.

- Rufen Sie Sicherheit > Zugriffs- und Datenkontrolle > API-Steuerung auf.

Klicken Sie auf Domainweite Delegierung verwalten.

Klicken Sie auf „Domainweite Delegierung verwalten“. Klicken Sie auf Neu hinzufügen.

Klicken Sie auf „Neu hinzufügen“. Führen Sie im Dialogfeld Neue Client-ID hinzufügen die folgenden Schritte aus:

- Client-ID: Geben Sie die Client-ID ein.

- OAuth-Bereiche: Geben Sie

https://www.googleapis.com/auth/directory.readonlyein. - Klicken Sie auf Autorisieren.

Konfigurieren Sie die Einstellungen für die domainweite Delegierung.

Datenspeicher für die Personensuche erstellen

So verwenden Sie die Console und nehmen die Personen-Daten auf:

Console

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Rufen Sie die Seite Datenspeicher auf.

Klicken Sie auf Datenspeicher erstellen.

Klicken Sie auf der Seite Quelle auf Personensuche.

Wählen Sie den Datenspeicher für die Personensuche aus. Konfigurieren Sie die Authentifizierungsdetails:

- Geben Sie die E-Mail-Adresse des Kontos ein, aus dem die Personendaten abgerufen werden. Wenn Sie kein Administratorkonto verwenden möchten, können Sie ein alternatives Konto mit Zugriff auf die Verzeichnisdaten der Organisation verwenden.

- Geben Sie die E-Mail-Adresse des Dienstkontos ein, das Sie im Abschnitt Dienstkonto einrichten erstellt haben.

- Klicken Sie auf Weiter.

Authentifizierungsdetails konfigurieren Wählen Sie eine Region für den Datenspeicher aus.

Wählen Sie die Häufigkeit der Synchronisierung für die vollständige Synchronisierung und optional für die inkrementelle Synchronisierung aus.

Einstellungen für die Häufigkeit der Synchronisierung für die vollständige und die inkrementelle Datensynchronisierung. Wenn Sie separate vollständige Synchronisierungen von Unternehmens- und Identitätsdaten planen möchten, maximieren Sie das Menü unter Vollständige Synchronisierung und wählen Sie Benutzerdefinierte Optionen aus.

Separate Zeitpläne für die vollständige Synchronisierung von Entitäten und Identitäten festlegen. Geben Sie im Feld Name des Datenspeichers einen Namen für den Datenspeicher ein.

Klicken Sie auf Erstellen. Die Synchronisierung kann je nach Datengröße einige Minuten bis Stunden dauern.

Datensynchronisierung pausieren oder fortsetzen

Sie können sowohl vollständige als auch inkrementelle Synchronisierungen pausieren und fortsetzen.

Wenn Sie eine Synchronisierung pausieren möchten, klicken Sie auf Synchronisierung pausieren/fortsetzen.

Wenn Sie eine Synchronisierung pausieren, werden alle zukünftigen geplanten Synchronisierungen abgebrochen. Wenn jedoch eine Synchronisierung aktiv ausgeführt wird, wenn Sie auf Synchronisierung pausieren/fortsetzen klicken, wird diese Synchronisierung nicht pausiert, sondern bis zum Abschluss fortgesetzt.

Wenn Sie eine Synchronisierung fortsetzen möchten, klicken Sie auf Synchronisierung pausieren/fortsetzen.

Wenn Sie einen Synchronisierungstyp fortsetzen, plant der Connector die neue Synchronisierung basierend auf der letzten geplanten Synchronisierungszeit.

Suchergebnisse anpassen

So schließen Sie personenbezogene Daten in die Suchergebnisse ein oder schließen sie aus:

Klicken Sie in Ihrem Datenspeicher auf den Tab Entität und dann auf Nutzer.

Klicken Sie auf den Tab „Entität“ des Datenspeichers. Klicken Sie auf der Seite Nutzer auf den Tab Schema.

Klicken Sie auf Bearbeiten.

Schema des Datenspeichers bearbeiten Wählen Sie die Attribute aus, z. B. das Land, die abrufbar, durchsuchbar und indexierbar sein sollen, oder heben Sie die Auswahl auf.

Klicken Sie auf Speichern.

Speichern Sie die Änderungen am Schema.

Fehlermeldungen

In der folgenden Tabelle werden Fehlermeldungen beschrieben, die beim Synchronisieren von Personendaten mithilfe der Datenindexierung auftreten können. Diese Tabelle enthält gRPC-Fehlercodes und Vorschläge zur Fehlerbehebung.

| Fehlercode (gRPC) | Fehlermeldung | Beschreibung | Fehlerbehebung |

|---|---|---|---|

| 9 (Nicht erfüllte Voraussetzung) | Fehler bei der Authentifizierung. Die Dienstkontoberechtigungen sind nicht richtig eingerichtet. Für diesen Datenspeicher wurde ein Wipeout ausgelöst und alle Dokumente wurden gelöscht. | Dieser Fehler tritt auf, wenn dem Discovery Engine-Dienstkonto die Rolle „Ersteller von Dienstkonto-Tokens“ fehlt oder dem Dienstkonto für die domainweite Delegation (DWD) der richtige Autorisierungsbereich fehlt. | Prüfen Sie, ob dem Discovery Engine-Dienstkonto die Rolle „Dienstkonto-Tokenersteller“ zugewiesen ist, und richten Sie den DWD-Dienstkonto-Autorisierungsbereich in Google Cloud Admin richtig ein. Gewähren Sie die fehlenden Dienstkontoberechtigungen noch einmal. |

| 9 (Nicht erfüllte Voraussetzung) | Nach der vollständigen Synchronisierung wurden keine Ergebnisse abgerufen. Für diesen Datenspeicher wurde ein Wipeout ausgelöst und alle Dokumente wurden gelöscht. | Dieser Fehler tritt auf, wenn die Kontaktfreigabe in den Verzeichniseinstellungen der Admin-Konsole deaktiviert ist. | Prüfen Sie, ob die Kontaktfreigabe in den Verzeichniseinstellungen der Admin-Konsole aktiviert ist. |

| 3 (Ungültiges Argument) | Das signierte JWT konnte nicht gegen ein Zugriffstoken eingetauscht werden. Das Google Workspace-Konto wurde gelöscht. Für diesen Datenspeicher wurde ein Wipeout ausgelöst und alle Dokumente wurden gelöscht. | Dieser Fehler tritt auf, wenn das Google Workspace-Konto gelöscht wird. | Erstellen Sie einen neuen Connector mit einem aktiven Google Workspace-Konto. |

| 3 (Ungültiges Argument) | GAIA-ID nicht gefunden. Fehler bei der Authentifizierung. | Dieser Fehler tritt auf, wenn das Nutzerkonto falsch ist. | Prüfen Sie, ob das Nutzerkonto vorhanden ist, und geben Sie die richtigen Anmeldedaten ein. |

| 8 (Resource exhausted) | Das Kontingent für das Projekt wurde überschritten. Erhöhen Sie das Dokumentkontingent für das Projekt. | Dieser Fehler tritt auf, wenn das Projektkontingent überschritten wird. | Erhöhen Sie das Dokumentkontingent für das Projekt. Weitere Informationen finden Sie unter Kontingente. |

| 13 (Interner Fehler) | Ein interner Fehler ist aufgetreten. | Dieser Fehler tritt auf, wenn ein interner Fehler vorliegt. | Wenden Sie sich an das Supportteam. |

Nächste Schritte

Wenn Sie Ihren Datenspeicher an eine App anhängen möchten, erstellen Sie eine App und wählen Sie Ihren Datenspeicher aus. Folgen Sie dazu der Anleitung unter Suchanwendung erstellen.

Informationen dazu, wie Sie Suchergebnisse erhalten, nachdem Ihre App und Ihr Datenspeicher eingerichtet wurden, finden Sie unter Suchergebnisse abrufen.

Aus Cloud SQL importieren

So nehmen Sie Daten aus Cloud SQL auf:

Zugriff auf Staging-Bucket für Cloud SQL-Instanzen einrichten

Beim Erfassen von Daten aus Cloud SQL werden die Daten zuerst in einem Cloud Storage-Bucket bereitgestellt. So gewähren Sie einer Cloud SQL-Instanz Zugriff auf Cloud Storage-Buckets:

Rufen Sie in der Google Cloud -Console die Seite SQL auf.

Klicken Sie auf die Cloud SQL-Instanz, aus der Sie Daten importieren möchten.

Kopieren Sie die ID des Dienstkontos der Instanz, die wie eine E-Mail-Adresse aussieht, z. B.

[email protected].Zur Seite IAM & Verwaltung.

Klicken Sie auf Zugriff erlauben.

Geben Sie unter Neue Hauptkonten die Dienstkonto-ID der Instanz ein und wählen Sie die Rolle Cloud Storage > Storage-Administrator aus.

Klicken Sie auf Speichern.

Nächster Schritt:

Wenn sich Ihre Cloud SQL-Daten im selben Projekt wie Vertex AI Search befinden, rufen Sie Daten aus Cloud SQL importieren auf.

Wenn sich Ihre Cloud SQL-Daten in einem anderen Projekt als Ihrem Vertex AI Search-Projekt befinden, lesen Sie den Abschnitt Cloud SQL-Zugriff aus einem anderen Projekt einrichten.

Cloud SQL-Zugriff über ein anderes Projekt einrichten

So gewähren Sie Vertex AI Search Zugriff auf Cloud SQL-Daten in einem anderen Projekt:

Ersetzen Sie die folgende Variable

PROJECT_NUMBERdurch die Projektnummer Ihres Vertex AI Search-Projekts und kopieren Sie dann den Inhalt des Codeblocks. Das ist die Kennung Ihres Vertex AI Search-Dienstkontos:service-PROJECT_NUMBER@gcp-sa-discoveryengine.iam.gserviceaccount.com`Zur Seite IAM & Verwaltung.

Wechseln Sie auf der Seite IAM und Verwaltung zu Ihrem Cloud SQL-Projekt und klicken Sie auf Zugriff erlauben.

Geben Sie unter Neue Hauptkonten die Kennzeichnung für das Dienstkonto ein und wählen Sie die Rolle Cloud SQL > Cloud SQL-Betrachter aus.

Klicken Sie auf Speichern.

Daten aus Cloud SQL importieren

Daten aus Cloud SQL importieren

Console

So nehmen Sie Daten aus Cloud SQL über die Console auf:

Rufen Sie in der Google Cloud Console die Seite KI-Anwendungen auf.

Rufen Sie die Seite Datenspeicher auf.

Klicken Sie auf Neuer Datenspeicher.

Wählen Sie auf der Seite Quelle die Option Cloud SQL aus.

Geben Sie die Projekt‑ID, die Instanz‑ID, die Datenbank‑ID und die Tabellen‑ID der Daten an, die Sie importieren möchten.

Klicken Sie auf Durchsuchen, wählen Sie einen temporären Cloud Storage-Speicherort aus, in den die Daten exportiert werden sollen, und klicken Sie dann auf Auswählen. Alternativ können Sie den Standort direkt in das Feld

gs://eingeben.Wählen Sie aus, ob der serverlose Export aktiviert werden soll. Für den serverlosen Export fallen zusätzliche Kosten an. Informationen zum serverlosen Export finden Sie in der Cloud SQL-Dokumentation unter Leistungseinbußen durch Exporte minimieren.

Klicken Sie auf Weiter.

Wählen Sie eine Region für den Datenspeicher aus.

Geben Sie einen Namen für den Datenspeicher ein.

Klicken Sie auf Erstellen.

Wenn Sie den Status der Aufnahme prüfen möchten, rufen Sie die Seite Datenspeicher auf und klicken Sie auf den Namen des Datenspeichers, um Details dazu auf der Seite Daten aufzurufen. Wenn sich die Statusspalte auf dem Tab Aktivität von Wird ausgeführt in Import abgeschlossen ändert, ist die Aufnahme abgeschlossen.

Je nach Größe der Daten kann die Datenaufnahme einige Minuten oder mehrere Stunden dauern.

REST

So erstellen Sie einen Datenspeicher und nehmen Daten aus Cloud SQL auf:

Datenspeicher erstellen.

curl -X POST \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ -H "X-Goog-User-Project: PROJECT_ID" \ "https://discoveryengine.googleapis.com/v1alpha/projects/PROJECT_ID/locations/global/collections/default_collection/dataStores?dataStoreId=DATA_STORE_ID" \ -d '{ "displayName": "DISPLAY_NAME", "industryVertical": "GENERIC", "solutionTypes": ["SOLUTION_TYPE_SEARCH"], }'Ersetzen Sie Folgendes:

PROJECT_ID: die Projekt-ID.DATA_STORE_ID: die ID des Datenspeichers. Die ID darf nur Kleinbuchstaben, Ziffern, Unterstriche und Bindestriche enthalten.DISPLAY_NAME: Der Anzeigename des Datenspeichers. Dies wird möglicherweise in der Google Cloud Console angezeigt.

Daten aus Cloud SQL importieren

curl -X POST \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://discoveryengine.googleapis.com/v1/projects/PROJECT_ID/locations/global/collections/default_collection/dataStores/DATA_STORE_ID/branches/0/documents:import" \ -d '{ "cloudSqlSource": { "projectId": "SQL_PROJECT_ID", "instanceId": "INSTANCE_ID", "databaseId": "DATABASE_ID", "tableId": "TABLE_ID", "gcsStagingDir": "STAGING_DIRECTORY" }, "reconciliationMode": "RECONCILIATION_MODE", "autoGenerateIds": "AUTO_GENERATE_IDS", "idField": "ID_FIELD", }'Ersetzen Sie Folgendes: