InfluxDB入门指南

发布时间: 2024-12-21 11:50:48 阅读量: 184 订阅数: 27

influxdb中文文档

# 摘要

本文为InfluxDB数据库的全面指南,详细介绍了其安装、核心概念、基本操作、查询语言和高级配置。首先,对InfluxDB进行简介并指导安装过程。接着深入探讨了InfluxDB的核心概念,包括时间序列数据的存储管理、数据模型及写入操作。文中还涵盖了InfluxDB基本操作和查询语言InfluxQL的使用,提供了查询优化技巧和高级特性介绍。通过实践应用案例,展示了InfluxDB在监控系统、日志分析以及物联网数据管理中的实际应用。最后,详细讲解了如何进行InfluxDB的高级配置和性能调优,包括集群部署、存储引擎、压缩策略和安全性与权限管理。本文旨在为读者提供一套完整的InfluxDB操作和优化知识体系,帮助他们充分利用InfluxDB的强大功能。

# 关键字

InfluxDB;时间序列数据;查询语言;集群管理;性能调优;数据压缩

参考资源链接:[InfluxDB时间序列数据库中文教程:从入门到实践](https://wenku.csdn.net/doc/6401abfbcce7214c316ea341?spm=1055.2635.3001.10343)

# 1. InfluxDB简介与安装

## 1.1 InfluxDB概述

InfluxDB是一款开源的时间序列数据库,特别设计用于高效处理高写入吞吐量的数据。它被广泛应用于监控系统、日志分析、物联网(IoT)、应用度量、实时分析等多个领域。InfluxDB拥有易用的HTTP API和强大的查询语言(InfluxQL),加上其灵活的数据模型,使得它成为处理时间序列数据的理想选择。

## 1.2 安装InfluxDB

InfluxDB可以通过多种方式安装,包括预编译的包、Docker镜像以及直接从源代码编译。这里以在Debian系统的包管理器为例,介绍如何安装InfluxDB:

```bash

# 添加InfluxDB的官方仓库

echo "deb https://repos.influxdata.com/debian stable main" | sudo tee /etc/apt/sources.list.d/influxdb.list

# 导入仓库的密钥

sudo curl -sL https://repos.influxdata.com/influxdb.key | sudo apt-key add -

# 更新包列表并安装InfluxDB

sudo apt-get update

sudo apt-get install influxdb

# 启动InfluxDB服务

sudo service influxdb start

```

安装完成后,InfluxDB服务将默认在`8086`端口上运行,并配置为自动启动。接下来,您可以通过访问`http://localhost:8086`来验证安装是否成功。安装完成后,您可能需要进一步配置InfluxDB以满足特定的使用需求,包括网络设置、认证、内存和存储配置等。

InfluxDB的安装仅是开始,它的强大功能和灵活性将在后续章节中深入探讨。

# 2. ```

# 第二章:InfluxDB核心概念深入解析

InfluxDB是一个专为时间序列数据设计的开源数据库,它提供了强大的数据存储、处理和查询能力。本章节将深入探讨InfluxDB的核心概念,包括时间序列数据的存储与管理、数据模型以及写入操作等内容。

## 2.1 时间序列数据的存储与管理

### 2.1.1 时间序列数据的特点

时间序列数据是指按照时间顺序排列的、以时间为索引的数据点集合。这类数据通常具有以下特点:

- **高频率采集**:数据采集间隔短,以实时或近实时的形式进行更新。

- **大数据量**:时间跨度大,数据量随着采集频率和时长成指数增长。

- **读写模式**:写操作通常追加新的数据点,读操作则关注历史数据的查询和分析。

- **趋势性**:数据往往用于分析随时间变化的趋势,如股票价格、温度变化等。

InfluxDB正是针对这些特点进行优化的数据库系统,它支持高效的数据存储和快速的查询能力,非常适合处理时间序列数据。

### 2.1.2 InfluxDB的数据结构

InfluxDB中的数据组织方式非常独特,它通过以下核心组件来存储时间序列数据:

- **Database (DB)**:数据库是存储measurement、retention policies、continuous queries、users和authors的容器。

- **Retention Policy (RP)**:保留策略定义了数据在数据库中的存储时间以及数据的分片策略,它是数据的存储规则。

- **Measurement**:测量是InfluxDB中的一个核心概念,它相当于关系型数据库中的表,用于存储一组相关数据点。

InfluxDB采用了列式存储方式,这意味着与传统行式存储相比,对于时间序列数据的查询和处理更加高效。此外,InfluxDB还使用了压缩技术来优化存储空间的使用。

## 2.2 InfluxDB的数据模型

### 2.2.1 概念(Database, Retention Policy, Measurement)

在InfluxDB中,数据模型的设计允许用户灵活地组织和存储时间序列数据。理解这些基本概念对于高效利用InfluxDB至关重要:

- **Database**:数据库是数据的集合,用于隔离不同的应用数据。

- **Retention Policy (RP)**:保留策略决定了数据在InfluxDB中的生命周期。每个RP定义了数据保留的时长(如“7天”、“30天”或“无限”)以及分片策略。

- **Measurement**:一个测量是一组具有相同时间戳和字段集的数据点,它是InfluxDB中数据模型的核心。

### 2.2.2 数据点(Points)与标签集(Tags Sets)

- **数据点(Point)**:这是InfluxDB中最小的数据单元,每个数据点包含一个时间戳、一个或多个字段值(field values),一个或多个标签(tags),以及与之相关的measurement名称。

示例代码展示如何使用InfluxDB的Line Protocol写入一个数据点:

```bash

influx -import -path=/path/to/data.txt -precision=rfc3339

```

在上述命令中,`-import`标志指定了要执行的导入操作,`-path`后跟数据文件的路径,`-precision`参数定义了时间戳的精度。

- **标签集(Tags Sets)**:标签是键值对,用于索引和分组数据点。标签在InfluxDB中被存储为列,这使得对于大量数据的查询和分组变得快速高效。

## 2.3 InfluxDB的写入操作

### 2.3.1 Line Protocol的使用

Line Protocol是InfluxDB用来写入数据的一种文本格式,它允许用户以结构化的方式提交数据。一条Line Protocol记录通常包含以下部分:

- Measurement

- Tags(可选)

- Fields

- Timestamp

InfluxDB使用如下格式接收数据:

```

<measurement>[,<tag-key><tag-value>[,<tag-key><tag-value>]] <field-key>=<field-value>[,<field-key>=<field-value>] [<timestamp>]

```

### 2.3.2 批量写入与性能考量

当需要高效地将数据写入InfluxDB时,推荐使用批量写入的方法。批量写入可以减少网络传输的次数和时间,提高数据写入速度。需要注意的是,InfluxDB在处理批量数据时会有一个默认的请求大小限制,超过了这个限制会引发错误。

为了优化性能,开发者可以通过调整InfluxDB的配置文件来增加批量处理的大小限制,或者在写入时手动控制批量数据的大小,确保每次写入操作都在限制之内。

至此,第二章已经介绍了InfluxDB核心概念的深入解析,接下来的章节将探讨InfluxDB的基本操作和查询语言,以及如何通过实践应用案例来进一步掌握InfluxDB的使用。

```

# 3. InfluxDB基本操作与查询语言

## 3.1 InfluxDB的查询语言入门

### SELECT语句基础

在InfluxDB中,查询语言被称为InfluxQL(Influx Query Language),它是一种类似于SQL的查询语言,专为处理时间序列数据而设计。使用InfluxQL进行数据查询时,基础的查询语句是由SELECT和FROM子句组成。

SELECT语句用于指定要查询的字段或数据点。字段可以是存储在InfluxDB中的实际数据,如温度、湿度等传感器读数。基本的查询语法如下:

```sql

SELECT <field_key>[,<field_key>,...] FROM <measurement_name>[,<measurement_name>,...] [WHERE <stuff>] [GROUP BY <stuff>]

```

每个`<field_key>`代表一个字段,而`<measurement_name>`代表存储这些字段的测量。在查询时,我们可以通过逗号分隔符来选择多个字段或测量。

### 聚合函数与GROUP BY的使用

时间序列数据通常需要进行聚合运算,如平均、求和、最小值或最大值等。InfluxQL提供了聚合函数来处理此类需求,常见的聚合函数包括:

- `mean()`:计算字段的平均值。

- `sum()`:计算字段的总和。

- `min()`:获取字段的最小值。

- `max()`:获取字段的最大值。

- `count()`:计算字段值的数量。

- `stddev()`:计算字段的标准偏差。

聚合函数可以在SELECT子句中使用,以对数据进行处理,如下所示:

```sql

SELECT mean("temperature") FROM "roomTemp" WHERE time > '2023-01-01T00:00:00Z' GROUP BY time(1h)

```

在这个例子中,查询了名为`roomTemp`的测量中`temperature`字段的平均值,并且结果按照每小时(`1h`)进行分组。

### 3.2 时间序列数据的查询优化

#### 时间范围与时间间隔的指定

查询时间序列数据时,通常需要指定一个时间范围。在InfluxDB中,这是通过`WHERE`子句实现的,其中可以设置起始时间和结束时间。例如:

```sql

SELECT "value" FROM "cpu" WHERE time >= '2023-01-01T10:00:00Z' AND time <= '2023-01-01T12:00:00Z'

```

同时,在进行查询时,合理地设置时间间隔`GROUP BY time()`,能够有效减少返回的数据量,并提高查询效率。时间间隔应根据实际的查询需求和存储的数据密度来调整。

#### 索引与数据查询效率

InfluxDB使用时间戳索引来加速查询。为了优化查询效率,重要的是确保你的数据被有效索引。数据点的索引基于`time`、`measurement`和`tag`值。通常,查询时尽量利用索引字段,避免不必要的全表扫描。例如,将查询限制在特定的tag上,可以使查询更加高效:

```sql

SELECT "value" FROM "cpu" WHERE "host" = 'serverA'

```

### 3.3 InfluxQL高级特性

#### JOIN操作与子查询

InfluxDB支持数据点的内连接(INNER JOIN)操作,这对于将来自不同测量或不同时间范围的数据进行合并查询十分有用。然而,由于时间序列数据的特殊性,使用`JOIN`时需要格外注意数据点的时间对齐问题。

```sql

SELECT mean("value") FROM "measurement1" WHERE time >= '2023-01-01T00:00:00Z' AND time <= '2023-01-02T00:00:00Z'

INNER JOIN mean("value") FROM "measurement2" WHERE time >= '2023-01-01T00:00:00Z' AND time <= '2023-01-02T00:00:00Z'

```

#### 用户定义函数(UDF)的实现

用户定义函数(UDF)在InfluxDB中用于更复杂的计算。UDF允许用户在查询中应用自定义逻辑,如脚本或函数。它是一个高级特性,允许用户通过JavaScript实现更复杂的聚合逻辑。UDF的实现需要在InfluxDB的查询界面或使用客户端API时附加相应的JavaScript代码。

```sql

SELECT my_udf_function("field1") FROM "measurement"

```

在本章节中,我们探索了InfluxDB的查询语言InfluxQL的基础知识、查询优化技巧以及一些高级特性。通过理解这些基础操作,你可以更加高效地利用InfluxDB来处理和分析时间序列数据。随着进一步的学习和实践,你将能够处理更加复杂的数据分析任务,并且在数据密集型应用场景中获得更好的性能。

# 4. InfluxDB实践应用案例

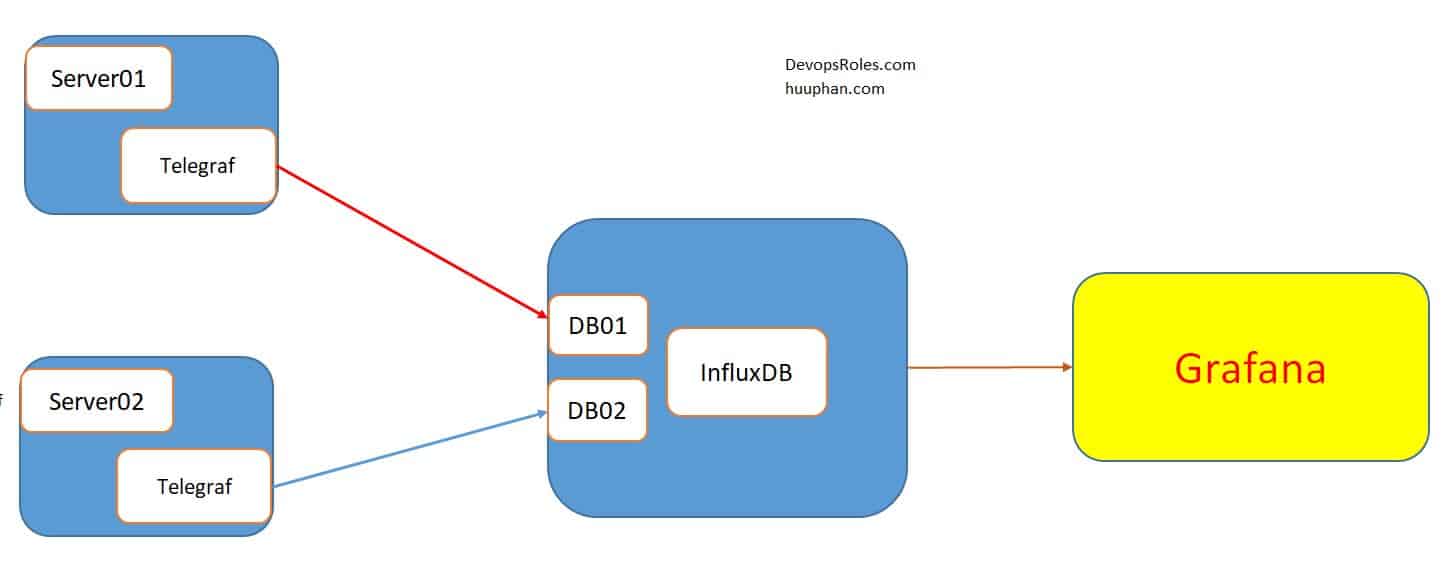

## 4.1 InfluxDB在监控系统中的应用

### 4.1.1 收集与存储系统指标

监控系统的数据收集和存储是任何监控平台的基础。InfluxDB因其专为处理时间序列数据而设计的特性,使其成为存储系统指标数据的理想选择。为了高效地收集和存储这些数据,首先需要在被监控的系统中部署相应的数据收集代理,如Telegraf。

```bash

# 安装Telegraf

sudo apt-get install telegraf

```

Telegraf 配置文件位于 `/etc/telegraf/telegraf.conf`。通过编辑此文件,可以配置输入插件以收集不同类型的系统指标数据。在配置文件中启用相应的插件后,Telegraf 会按预设的时间间隔从系统中收集数据,并将其发送到指定的 InfluxDB 实例。

```toml

# 示例:启用CPU和内存插件的Telegraf配置片段

[[inputs.cpu]]

percpu = true

totalcpu = true

collect_cpu_time = false

report_active = false

[[inputs.mem]]

percpu = true

total = true

```

在Telegraf配置完成后,数据会开始流向InfluxDB,并以时间序列的形式存储。可以通过InfluxQL查询来验证数据是否成功写入数据库:

```sql

# 查询最近的系统CPU使用率

SELECT mean("usage_system") FROM "cpu" WHERE time > now() - 1m;

```

### 4.1.2 告警规则的配置与触发

收集数据的目的不仅在于存储,还在于能够实时地响应系统状态的变化。InfluxDB结合Chronograf和Kapacitor可以实现强大的告警规则管理。

首先,需要安装Chronograf和Kapacitor:

```bash

# 安装Chronograf和Kapacitor

sudo apt-get install chronograf kapacitor

```

然后,通过Chronograf的Web界面创建一个通知通道,并定义告警规则。例如,当CPU使用率超过80%时触发告警:

```sql

# 定义告警规则的InfluxQL

CREATE ALERT RULE "high_cpu_usage" ON cpu

FOR "usage_system" > 80

EVERY 1m

CLEAR FOR 10m;

```

这会创建一个名为“high_cpu_usage”的告警规则。当“usage_system”字段的值超过80%时,Kapacitor将收到通知并在指定的通知通道中触发告警。这个过程是完全自动化和可配置的,允许IT管理员在数据异常情况下及时作出反应。

## 4.2 日志分析与实时数据处理

### 4.2.1 日志数据的导入与查询

日志数据是监控系统中的重要组成部分,InfluxDB提供了强大的日志处理能力。但是,日志数据通常是半结构化或非结构化的,因此需要一个预处理步骤来确保数据能够以时间序列格式存储。

利用Telegraf的Exec插件,可以运行自定义脚本来解析日志文件,并将解析后的数据写入InfluxDB。这里是一个简单的示例,展示如何配置Telegraf来处理名为`app.log`的日志文件:

```toml

[[inputs.exec]]

commands = [ "tail -n+1 -F /var/log/app.log" ]

data_format = "influx"

```

上述配置会持续跟踪`app.log`文件的更新,并将新行作为数据点发送到InfluxDB。

查询这些日志数据时,可以利用InfluxQL的强大功能来过滤和聚合结果:

```sql

# 查询特定模式的错误日志

SELECT * FROM "log" WHERE "message" =~ /Error/;

```

### 4.2.2 实时数据流的聚合与可视化

为了更好地理解日志数据流并实时监控其变化,InfluxDB可以与Grafana等数据可视化工具结合使用。首先,需要安装并配置Grafana服务器:

```bash

# 安装Grafana

sudo apt-get install grafana

```

接下来,在Grafana中添加InfluxDB作为数据源,并创建仪表板来展示日志数据的实时视图。比如,可以创建一个仪表板来展示访问量最高的日志条目:

```json

{

"panels": [

{

"title": "Top Log Entries",

"type": "table",

"queries": [

{

"refId": "A",

"query": "SELECT * FROM log WHERE time > now() - 1h GROUP BY * FILL(0)",

"resultFormat": "timeSeries"

}

]

}

]

}

```

通过上述步骤,可以将实时日志数据聚合并以表格形式展示。这些实时可视化图表对于识别系统问题和进行故障排查非常有用。

## 4.3 使用InfluxDB进行物联网数据管理

### 4.3.1 设备数据的采集与存储

物联网(IoT)设备经常需要发送时间序列数据到集中式的数据库,以便进行监控和分析。InfluxDB非常适合处理IoT场景,因为它的设计就是针对高速、高并发写入的场景。

通过使用IoT平台或自定义的网关设备,设备数据可以被转发到InfluxDB。在InfluxDB中,可以创建专门的measurement来保存特定类型的设备数据,比如传感器温度、湿度等。

例如,可以使用以下InfluxQL命令来创建新的measurement和对应的标签集:

```sql

# 创建新的measurement

CREATE DATABASE "iot_db"

WITH DURATION 30d

REPLICATION 1

SHARD DURATION 30d

```

一旦设备数据开始流动到InfluxDB,便可以使用InfluxQL进行实时查询和分析。例如,检查特定传感器在过去一小时内的平均温度:

```sql

# 查询特定传感器的平均温度

SELECT mean("temperature") FROM "sensor_data" WHERE "sensor_id" = 'sensor1' AND time > now() - 1h;

```

### 4.3.2 数据的实时分析与智能决策支持

InfluxDB不仅可以存储设备数据,还可以实时分析这些数据,并提供智能决策支持。例如,设备数据可以用来触发阈值告警,或者进行更复杂的预测分析以优化设备性能。

假设我们需要对设备温度数据设置告警,当温度超过设定阈值时通知相关人员:

```sql

# 定义温度阈值告警规则

CREATE ALERT RULE "high_temperature" ON "iot_db"."sensor_data"

FOR "temperature" > 50

EVERY 1m

CLEAR FOR 10m;

```

这样的告警规则可以帮助及时响应可能引起设备故障的条件。除了告警,通过分析时间序列数据还可以获得设备使用模式,为维护计划提供指导,或者为产品功能改进提供依据。

以上案例展示了InfluxDB在物联网数据管理中的应用。它的高性能和灵活性使其成为物联网解决方案中不可或缺的部分。通过上述实践应用,InfluxDB的实用性得到了全面的展现,从数据的收集与存储,到实时分析和智能决策支持,InfluxDB为处理时间序列数据提供了强大的平台。

# 5. InfluxDB高级配置与性能调优

随着物联网设备的普及与大数据的不断增长,对时间序列数据库的性能与安全性要求也随之提高。本章节将深入探讨如何通过高级配置与性能调优,最大化InfluxDB的潜力。

## 5.1 InfluxDB集群的部署与管理

InfluxDB支持通过集群模式提供高可用性和水平扩展。集群能够处理更多的读写请求,同时保证数据的持久性和一致性。

### 5.1.1 集群模式的搭建

搭建InfluxDB集群涉及多个步骤,包括创建集群节点、初始化Meta节点和数据节点,并确保它们之间的通信。

```shell

# 创建Meta节点

influxd init --meta --config meta.conf

# 启动Meta节点

influxd -config meta.conf

# 创建数据节点,指定Meta节点

influxd -config data.conf -join <meta_node_ip>:8091

```

以上代码块展示了如何使用命令行初始化Meta节点和数据节点,并通过指定Meta节点的IP地址和端口加入集群。

### 5.1.2 负载均衡与故障转移

集群的负载均衡由内置的HTTP负载均衡器实现,支持Round Robin、Random和Least Connections三种算法。

```mermaid

flowchart LR

A[客户端] --> B[负载均衡器]

B --> C[InfluxDB节点1]

B --> D[InfluxDB节点2]

B --> E[InfluxDB节点3]

C -.-> F[故障转移]

D -.-> F

E -.-> F

F --> G[客户端]

```

如上所示的mermaid流程图,客户端请求首先到达负载均衡器,然后按照配置的算法分发到各个InfluxDB节点。当某个节点出现故障时,负载均衡器会自动将请求转移至其他节点,确保服务的连续性。

## 5.2 InfluxDB的存储引擎与压缩策略

InfluxDB的存储引擎是其核心组件之一,负责高效地写入和查询数据。TSM(Time Structured Merge Tree)是InfluxDB使用的存储引擎,它为时间序列数据优化了存储和查询。

### 5.2.1 TSM引擎的工作原理

TSM引擎通过结合LSM(Log-Structured Merge-Tree)和B+ Tree的优点,提高了写入和查询性能。数据首先写入到内存中,当满足特定条件时,数据会被写入到磁盘。数据在磁盘上是压缩存储的,有利于减少磁盘I/O和存储空间的需求。

### 5.2.2 数据压缩与存储优化

TSM通过时间序列数据的连续性,实施有效的压缩算法,如时间戳和值的编码压缩。可以进一步减少存储空间的占用,并提升查询性能。

```shell

# 开启压缩功能

[http]

enabled = true

# 设置压缩的存储阈值

[tsm]

data = "/var/lib/influxdb/data"

wal = "/var/lib/influxdb/wal"

cache-max-memory-size = "1g"

```

以上代码段展示了InfluxDB配置文件中相关压缩功能的设置选项。

## 5.3 安全性与权限管理

安全性与权限管理是生产环境中不可或缺的部分。InfluxDB提供了一套完整的用户认证与授权机制,确保数据的安全性。

### 5.3.1 用户认证与授权

通过配置文件或管理命令设置用户账户,并赋予相应的读写权限。

```shell

# 创建具有管理员权限的用户

influx -execute 'CREATE USER <admin_user> WITH PASSWORD <admin_pass> WITH ALL PRIVILEGES'

# 验证用户登录

influx -username <admin_user> -password <admin_pass>

```

以上是使用命令行创建用户并验证其登录的示例。

### 5.3.2 数据备份与恢复策略

确保数据安全的另一个重要方面是定期备份和在需要时能够恢复数据。InfluxDB提供了强大的备份与恢复功能。

```shell

# 备份数据库

influxd backup -portable <backup_path>

# 恢复数据库

influxd restore -portable <backup_path> -newdb <new_database>

```

通过上述命令,可以轻松地备份和恢复InfluxDB中的数据。备份文件是跨版本兼容的,这为数据恢复提供了极大的灵活性。

本章内容为读者提供了InfluxDB在高级配置和性能调优方面的深度解析,帮助开发者和运维人员更高效地管理和优化InfluxDB的运行。后续章节将探讨InfluxDB在不同应用场景下的实践案例,展示如何将InfluxDB应用于实际业务中。

0

0