Мастер-класс по BigData Tools для HappyDev'15

- 1. BigData Tools Зиновьев Алексей Java/BigData тренер в EPAM

- 3. Контакты • https://twitter.com/zaleslaw • https://twitter.com/BigDataRussia • http://vk.com/big_data_russia Big Data Russia • http://vk.com/java_jvm

- 4. JavaScript изо всех щелей

- 5. И вот, что я скажу тебе, JavaScript

- 6. И вот, что я скажу тебе, JavaScript

- 7. Мне нравится, когда все на JVM крутится!

- 8. Типичный BigData кластер • 450 машин • Master Nodes (24 ядра, 158 Gb RAM). • Data Nodes (24|32 ядра, 96|128 Gb RAM). • Средняя YARN Queue utilization 85% (по дням). • 12Pb – емкость хранения данных

- 9. Когда мы говорим, что имеем дело с BigData решением • Когда перед глазами смесь архитектурных подходов, таких как Kappa, Lambda, Data Lake • Когда мы имеем дело со стеком технологий, таких как Hadoop, Kafka, Spark, Storm, Samza, HBase, Cassandra, Titan, GridGain • Когда анализ логов этих систем – задача не менее серьезного уровня

- 10. ScaleUp vs ScaleOut 16 CPUs 16 CPUs 16 CPUsScale - Out16 CPUs 48 CPUsScale - Up16 CPUs

- 11. Приходит время, данные в датацентры улетают… I 50GB 300GB 5TB

- 12. Приходит время, данные в датацентры улетают…

- 13. Как вылечить невысокую устойчивость к сбоям?

- 14. Мыть голову при помощи нового шампуня «Репликация»!

- 15. Если вы слишком увлечётесь гонкой инструментов, то получится..

- 16. Типичный многосервисный проект, где основной болью будет конфликт разных версий Real-Time Data-Marts Batch Data-Marts Relations Graph Ontology Metadata Search Index Events & Alarms Real-time Dashboarding Events & Alarms All Raw Data backup is stored here Real-time Data Ingestion Batch Data Ingestion Real-Time ETL & CEP Batch ETL & Raw Area Scheduler Internal External Social HDFS → CFS as an option Time-Series Data Titan & KairosDB store data in Cassandra Push Events & Alarms (Email, SNMP etc.)

- 17. Hadoop

- 18. Пора дать определение! • Hadoop != MapReduce

- 19. Пора дать определение! • Hadoop != MapReduce • Hadoop – это фреймворк

- 20. Пора дать определение! • Hadoop != MapReduce • Hadoop – это фреймворк • Фреймворк для обработки больших массивов данных

- 21. Пора дать определение! • Hadoop != MapReduce • Hadoop – это фреймворк • Фреймворк для обработки больших массивов данных • Который использует простые модели и парадигмы программирования

- 22. Пора дать определение! • Hadoop != MapReduce • Hadoop – это фреймворк • Фреймворк для обработки больших массивов данных • Который использует простые модели и парадигмы программирования • Скрывая от нас всю самую сложную часть с параллелизацией, перемещением данных и

- 23. Фреймворке в семействе Hadoop • Универсальные (MapReduce, Tez, Kudu, RDD in Spark)

- 24. Фреймворке в семействе Hadoop • Универсальные (MapReduce, Tez, Kudu, RDD in Spark) • Абстрактные (Pig, Pipeline Spark)

- 25. Фреймворке в семействе Hadoop • Универсальные (MapReduce, Tez, Kudu, RDD in Spark) • Абстрактные (Pig, Pipeline Spark) • SQL – подобные (Hive, Impala, Spark SQL)

- 26. Фреймворке в семействе Hadoop • Универсальные (MapReduce, Tez, Kudu, RDD in Spark) • Абстрактные (Pig, Pipeline Spark) • SQL – подобные (Hive, Impala, Spark SQL) • Для обработки графов (Giraph, GraphX)

- 27. Фреймворке в семействе Hadoop • Универсальные (MapReduce, Tez, Kudu, RDD in Spark) • Абстрактные (Pig, Pipeline Spark) • SQL – подобные (Hive, Impala, Spark SQL) • Для обработки графов (Giraph, GraphX) • Машинное обучение (MLlib, Mahout)

- 28. Фреймворке в семействе Hadoop • Универсальные (MapReduce, Tez, Kudu, RDD in Spark) • Абстрактные (Pig, Pipeline Spark) • SQL – подобные (Hive, Impala, Spark SQL) • Для обработки графов (Giraph, GraphX) • Машинное обучение (MLlib, Mahout) • Stream (Spark Streaming, Storm)

- 31. Важнейшие части «слона» • Hadoop Commons • Hadoop Clients • HDFS – Hadoop Distributed File System • Yarn – Yet Another Resource Negotiator • MapReduce

- 32. Как начать?

- 33. Как начать? С выбора дистрибутива, конечно

- 34. Важнейшие части «слона» • Apache Hadoop 2.7.1 • Hortonworks HDP 2.3 2.7.1 • Cloudera CDH 5.4.4 2.6.0 • MapR 5.0 2.7.0 • Pivotal HD 3.0 2.6.0 • other

- 35. HDP != Hadoop

- 36. HDP != Hadoop

- 37. Русские ставят вручную на первый попавшийся сервер

- 38. Нравится много писать в консоли? Big Data on your local machine : How to install Hadoop 2.6.0

- 39. Режим установки local • Однопоточная Java • Легко дебажить даже из IDE • Репликации нет • HDFS учить не нужно • dfs.replication=“1”; • fs.defaultFS=“file:///”; fs.default.name=“file:///”; • mapreduce.framework.name=“local”

- 40. Режим установки Pseudo-distributed • Все на одной ноде • Репликации нет • Каждому демону из Hadoop соответсвует thread из Java • Yarn выполняет свою работу

- 41. Режим установки Fully-distributed • Репликация какая надо • Master/slave ноды • Yarn выполняет свою работу

- 42. Топология Hadoop

- 43. Best Practices • DataNodes, NodeManagers and RegionServers обычно разворачиваются исходя из стратегии DataLocality

- 44. Best Practices • DataNodes, NodeManagers and RegionServers обычно разворачиваются исходя из стратегии DataLocality • Обычно каждый блок данных реплицируется минимум трижды в действительно разных местах

- 45. Best Practices • DataNodes, NodeManagers and RegionServers обычно разворачиваются исходя из стратегии DataLocality • Обычно каждый блок данных реплицируется минимум трижды в действительно разных местах • Если можно, ставим балансировщик

- 46. Best Practices • DataNodes, NodeManagers and RegionServers обычно разворачиваются исходя из стратегии DataLocality • Обычно каждый блок данных реплицируется минимум трижды в действительно разных местах • Если можно, ставим балансировщик • Изучаем особенности HDFS

- 47. Рекомендации по мощностям • 64GB RAM для NameNode позволяют адресоваться ~100M files в HDFS • 256 GB RAM для data nodes и интенсивными in-memory operations (например Spark executors, или in-memory DBs) • Минимум 8-16 cores CPUs • Минимум 4 дисков (для master nodes) и 6-12 дисков (для data nodes) для IO optimization; + 1 отдельный диск для OS

- 48. HDFS

- 49. Hadoop Distributed File System Hortonworks утверждает, что существуют кластера на 200 PB, 4500 машин, > 10^6 файлов и HDFS нормально так работает

- 50. NameNode • Вообще это отдельные процессы, которые умеют жить как на одной, так и на разных машинах • В кластере только одна NameNode, но это не SPOF! • Есть StanbyNameNode, она страхует • Если NameNode недоступна, то недоступен и HDFS кластер

- 51. NameNode рулит и разруливает!

- 52. DataNode • DataNode может быть сколько угодно, чем больше, тем лучше • Можно убирать и добавлять их без особого ущерба • DataNode сама отвечает на запросы • И слушается NameNode, когда надо умереть, реплицировать что-то или удалить реплику

- 53. Что нужно уметь и знать! • Перемещать данные между HDFS и обычной FS: hdfs fs -copyFromLocal ; -copyToLocal • Удалять/создавать директории • Управлять правами на файлы/папки • Диагностировать • Проверять наличие свободного пространства Все это при помощи команд, похожих на Linux

- 54. Укротите демонов! • /logs • /logLevel • /stacks • /metrics • /metrics?format=json

- 55. MapReduce

- 56. MapReduce на уровне языков Language Code sample Java 8 Integer totalAge = persons .stream() .map(Person::getAge) .reduce( 0, (a, b) -> a + b); Scala val totalAge = persons .map( (p: Person) => p.getAge ) .reduce( _ + _ ) Python totalAge = reduce( (lambda a, b: a + b), list( map(lambda p: p.getAge, persons) ) )

- 58. WordCount, отлитый в Java : Mapper

- 59. WordCount, отлитый в Java : Reducer

- 60. WordCount, отлитый в Java : Runner

- 61. WordCount, отлитый в Java : Runner

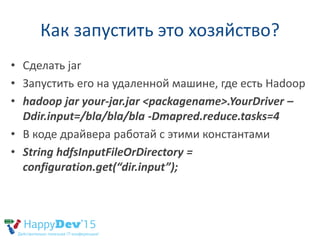

- 62. Как запустить это хозяйство? • Сделать jar

- 63. Как запустить это хозяйство? • Сделать jar • Запустить его на удаленной машине, где есть Hadoop

- 64. Как запустить это хозяйство? • Сделать jar • Запустить его на удаленной машине, где есть Hadoop • hadoop jar your-jar.jar <packagename>.YourDriver – Ddir.input=/bla/bla/bla -Dmapred.reduce.tasks=4

- 65. Как запустить это хозяйство? • Сделать jar • Запустить его на удаленной машине, где есть Hadoop • hadoop jar your-jar.jar <packagename>.YourDriver – Ddir.input=/bla/bla/bla -Dmapred.reduce.tasks=4 • В коде драйвера работай с этими константами

- 66. Как запустить это хозяйство? • Сделать jar • Запустить его на удаленной машине, где есть Hadoop • hadoop jar your-jar.jar <packagename>.YourDriver – Ddir.input=/bla/bla/bla -Dmapred.reduce.tasks=4 • В коде драйвера работай с этими константами • String hdfsInputFileOrDirectory = configuration.get(“dir.input”);

- 67. Запустили? Упало! Нужны тесты Вот бы нам JUnit…

- 68. Запустили? Упало! Нужны тесты public class MRUnitHelloWorld { MapDriver<LongWritable, Text, Text, IntWritable> mapDriver; @Before public void setUp() { WordMapper mapper = new WordMapper(); mapDriver = new MapDriver<LongWritable, Text, Text, IntWritable>(); mapDriver.setMapper(mapper); } @Test public void testMapper() { mapDriver.withInput(new LongWritable(1), new Text("cat dog")); mapDriver.withOutput(new Text("cat"), new IntWritable(1)); mapDriver.withOutput(new Text("dog"), new IntWritable(1)); mapDriver.runTest(); } }

- 69. Hadoop Jobs

- 70. Не забывай о JVM!

- 71. Но всеми этим фронтами кто-то должен управлять, говорить кому когда что делать…

- 72. Скелет Hadoop, который пришелся по вкусу всем!

- 73. YARN

- 74. MapReduce – это всего лишь одно приложение, которое приходит к всемогущему YARN за ресурсами для своих авантюр

- 75. YARN общается с HDFS, чтобы задействовать DataLocality и оптимизировать свои ресурсы

- 76. YARN управляет жизненным циклом, нудно, но все работает!

- 77. Как извлекать факты для анализа данных из Hadoop?

- 78. Свин и шмелле летят на помощь!

- 79. Pig

- 80. Подсчет треугольников в графе

- 81. Pig Scripts -> MapReduce jobs

- 82. Сделаем отчет на Pig dem = LOAD '/ok/demography/part-r-00000' AS (id:int, age:int, gender:int, region:int);

- 83. Сделаем отчет на Pig dem = LOAD '/ok/demography/part-r-00000' AS (id:int, age:int, gender:int, region:int); logins = LOAD '/ok/logins/*' AS (ts:chararray, userid:int, clientType:int, success:boolean, geoIp:int, userAgent:int);

- 84. Сделаем отчет на Pig dem = LOAD '/ok/demography/part-r-00000' AS (id:int, age:int, gender:int, region:int); logins = LOAD '/ok/logins/*' AS (ts:chararray, userid:int, clientType:int, success:boolean, geoIp:int, userAgent:int); by_user_success = GROUP logins BY (userid, success);

- 85. Сделаем отчет на Pig dem = LOAD '/ok/demography/part-r-00000' AS (id:int, age:int, gender:int, region:int); logins = LOAD '/ok/logins/*' AS (ts:chararray, userid:int, clientType:int, success:boolean, geoIp:int, userAgent:int); by_user_success = GROUP logins BY (userid, success); logins_data = FOREACH by_user_success GENERATE FLATTEN (group) as (userid, success), COUNT(logins.ts) as login_amount;

- 86. Сделаем отчет на Pig dem = LOAD '/ok/demography/part-r-00000' AS (id:int, age:int, gender:int, region:int); logins = LOAD '/ok/logins/*' AS (ts:chararray, userid:int, clientType:int, success:boolean, geoIp:int, userAgent:int); by_user_success = GROUP logins BY (userid, success); logins_data = FOREACH by_user_success GENERATE FLATTEN (group) as (userid, success), COUNT(logins.ts) as login_amount; DESCRIBE logins_data;

- 87. Сделаем отчет на Pig /* amount of logins by regions */ dem_logins= JOIN dem BY id, logins_data BY userid;

- 88. Сделаем отчет на Pig /* amount of logins by regions */ dem_logins= JOIN dem BY id, logins_data BY userid; by_region = GROUP dem_logins BY (region, gender, success);

- 89. Сделаем отчет на Pig /* amount of logins by regions */ dem_logins= JOIN dem BY id, logins_data BY userid; by_region = GROUP dem_logins BY (region, gender, success); result = FOREACH by_region GENERATE FLATTEN (group) as (region, gender, success), SUM(dem_logins.login_amount) as login_amount;

- 90. Сделаем отчет на Pig /* amount of logins by regions */ dem_logins= JOIN dem BY id, logins_data BY userid; by_region = GROUP dem_logins BY (region, gender, success); result = FOREACH by_region GENERATE FLATTEN (group) as (region, gender, success), SUM(dem_logins.login_amount) as login_amount; DESCRIBE result;

- 91. Сделаем отчет на Pig /* amount of logins by regions */ dem_logins= JOIN dem BY id, logins_data BY userid; by_region = GROUP dem_logins BY (region, gender, success); result = FOREACH by_region GENERATE FLATTEN (group) as (region, gender, success), SUM(dem_logins.login_amount) as login_amount; DESCRIBE result; STORE result INTO '/ok/dem_logins_by_region' using PigStorage(',');

- 92. Да по-любому надо тюнить! set default_parallel 64; set job.name Calculate_number_of_users; set mapred.child.java.opts -Xmx1024m dem = LOAD '/ok/demography/part-r-00000' AS (id:int, age:int, gender:int, region:int); ….

- 93. Hive

- 94. Как так? Снова SQL? Да, дружище, он никуда не уходил, стоял за дверью…

- 95. Причины триумфа Hive • Иллюзия структуры • Единый язык для различных хранилищ • SQL всем знаком • Вполне реален ответ за небольшое время • MapReduce слишком сложен • Иллюзия JOINs

- 98. JOINы превращаются.. в элегантные шорты

- 99. Spark

- 100. Почему мамонты вымирают? • Они слишком часто сохраняются на диск

- 101. Почему мамонты вымирают? • Они слишком часто сохраняются на диск • Слишком много людей сидят на абстракциях, а не пишут MR jobs

- 102. Почему мамонты вымирают? • Они слишком часто сохраняются на диск • Слишком много людей сидят на абстракциях, а не пишут MR jobs • Слишком плох MR для итерационных вычислений

- 103. Почему мамонты вымирают? • Они слишком часто сохраняются на диск • Слишком много людей сидят на абстракциях, а не пишут MR jobs • Слишком плох MR для итерационных вычислений • Слишком долго MR был на коне

- 104. Почему мамонты вымирают? • Они слишком часто сохраняются на диск • Слишком много людей сидят на абстракциях, а не пишут MR jobs • Слишком плох MR для итерационных вычислений • Слишком долго MR был на коне • И да, Google его больше не использует

- 105. Мы можем комбинировать подходы для всех источников данных val points = spark.sql("select latitude, longitude from tweets") val model = KMeans.train(points, 10)

- 106. WordCount на Scala + Spark val conf = new SparkConf() .setAppName(appName) .setMaster(master)

- 107. WordCount на Scala + Spark val conf = new SparkConf() .setAppName(appName) .setMaster(master) val spark = new SparkContext(conf)

- 108. WordCount на Scala + Spark val conf = new SparkConf() .setAppName(appName) .setMaster(master) val spark = new SparkContext(conf) val file = spark.textFile("…") res.saveAsTextFile("…");

- 109. WordCount на Scala + Spark val conf = new SparkConf() .setAppName(appName) .setMaster(master) val spark = new SparkContext(conf) val file = spark.textFile("…") Тут как напишем сейчас MR! res.saveAsTextFile("…");

- 110. WordCount на Scala + Spark val conf = new SparkConf() .setAppName(appName) .setMaster(master) val spark = new SparkContext(conf) val file = spark.textFile("…") val res = file .flatMap(line => line.split(" ")) .map(word => (word, 1)) .reduceByKey(_+_) res.saveAsTextFile("…");

- 111. Основные компоненты

- 112. Типичный итерационный алгоритм до и после.. 10x – 100x

- 113. Spark – это не царская дорога к большим данным Статья о том, что меня раздражает в Spark

- 114. Контакты • https://twitter.com/zaleslaw • https://twitter.com/BigDataRussia • http://vk.com/big_data_russia Big Data Russia • http://vk.com/java_jvm