Casual learning machine learning with_excel_no5

- 1. カジュアル勉強会 @仙台 Excelで機械学習入門 第5回 株式会社 エクテック データサイエンティスト

- 4. Excel 2013, 2016 Google Spreadsheets

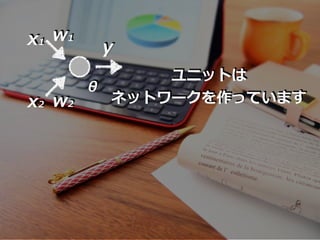

- 9. ニューラルネットワーク

- 12. 『⼈の脳を模し』た

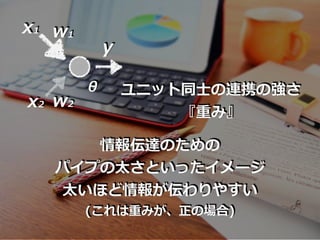

- 18. x1 x2 x3 y 出⼒ ⼊⼒ w1 w2 w3 重み ⼊⼒信号x1, x2, x3に対してsum s = w1x1 + w2x2 + w3x3 + θ 閾値 θ

- 19. 閾値重み ⼊⼒信号x1, x2, x3に対してsum s = w1x1 + w2x2 + w3x3 + θ これら重みや閾値は そのユニットの固有の値

- 20. x1 x2 xn y 出⼒ ⼊⼒ w1 w2 wn 重み n個の⼊⼒信号x1, x2, … , xn があれば s = w1x1 + w2x2 + … + wnxn + θ 閾値 θ ……

- 21. sに対して、出⼒値 yは... n個の⼊⼒信号x1, x2, … , xn があれば s = w1x1 + w2x2 + … + wnxn + θ y = a(s)

- 22. sに対して、出⼒値 yは... n個の⼊⼒信号x1, x2, … , xn があれば s = w1x1 + w2x2 + … + wnxn + θ y = a(s) 活性化関数 (activation function)

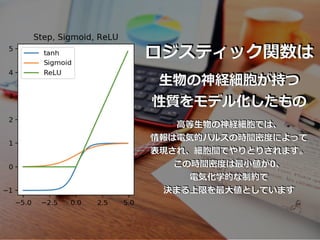

- 23. σ(s) = 1 1 + e -s ロジスティック関数

- 24. σ(s) = 1 1 + e -s tanh(s) = e - e e + e-ss -ss ハイパボリックタンジェント ロジスティック関数

- 25. ロジスティック関数 σ(s) = 1 1 + e -s tanh(s) = e - e e + e-ss -ss ハイパボリックタンジェント シグモイド関数 s < 0 のとき ReLU(s)=0 s ≧ 0 のとき ReLU(s)=s

- 26. σ(s) = 1 1 + e -s tanh(s) = e - e e + e-ss -ss ハイパボリックタンジェント シグモイド関数 s < 0 のとき ReLU(s)=0 s ≧ 0 のとき ReLU(s)=s 活性化関数の代表例 ロジスティック関数

- 31. シグモイド関数を活性化関数とする下図のような ユニットを考えます。⼊⼒x1, x2に対して、 重みを順にw1, w2とします。また、閾値をθ とします。このとき、出⼒yは次のように算出 されます。 s = w1x1 + w2x2 + θ y = σ(s) = 1 1 + e -s x1 x2 y w1 w2 θ

- 39. これらユニットを層状にしたもの

- 40. ニューラルネットワーク

- 42. 具体例で、考えてみましょう

- 43. 4 ✖ 3 画素の⽩⿊2値画像として読み取った 「0」,「1」の⼿書き⽂字画像を識別する ニューラルネットワークを作成します。

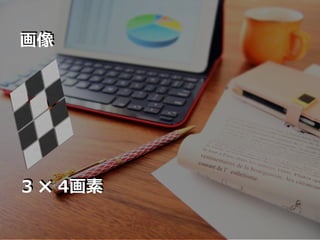

- 44. 3 ✖ 4画素 画像

- 48. 0 1 1 1 0 1 1 0 1 1 1 0 0 1 1 1 0 1 1 0 1 0 1 1 0 1 0 0 1 0 0 1 0 0 1 0 1 1 0 0 1 0 0 1 0 0 1 0 3 ✖ 4画素でも “0”, “1”の2値でも 「0」, 「1」を表現できる

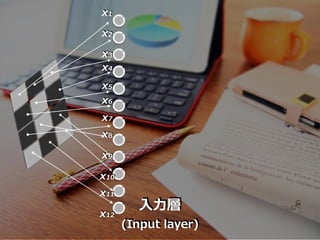

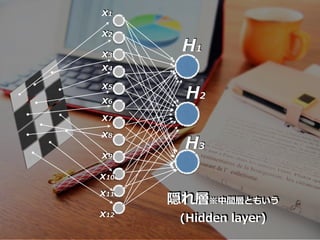

- 50. Xi Hj Zk 隠れ層 (Hidden layer) ⼊⼒層 (Input layer) 出⼒層 (Output layer) i は⼊⼒層の中の 上からの位置を ⽰すとする j は隠れ層の中の 上からの位置を ⽰すとする k は出⼒層の中の 上からの位置を ⽰すとする

- 51. Hj Zk Xi ユニットXi の出⼒xi ユニットHj の出⼒hj ユニットZkの出⼒zk ⼤⽂字は、ユニット名を ⼩⽂字は、ユニットの出⼒変数を表すことにします

- 52. sj 隠れ層 (Hidden layer) j番⽬のニューロン 出⼒層 (Output layer) k番⽬のニューロン ⼊⼒の 線形和 H θj H wji H ⼊⼒層 i番⽬の ニューロン sk ⼊⼒の 線形和 O θk O wkj O 隠れ層 j番⽬の ニューロン

- 53. i Xi Hj Zk i番⽬の ニューロン (i=1,2,...,12) j番⽬の ニューロン (j=1,2,3) k番⽬の ニューロン (k=1,2) wji H wkj O 隠れ層 (Hidden layer) 出⼒層 (Output layer) ⼊⼒層 (Input layer)

- 56. s1 = w11x1 + w12x2 + … + w112x12 + θ1 H H H H H s2 = w21x1 + w22x2 + … + w212x12 + θ2 H H H H H s3 = w31x1 + w32x2 + … + w312x12 + θ3 H H H H H h1 = a(S1) H h2 = a(S2) H h3 = a(S3) H ここで a は活性化関数

- 58. s1 = w11h1 + w12h2 +w13h3 + θ1 O O O z1 = a(S1) H z2 = a(S2) H ここで a は活性化関数 (ここでは便宜上活性化関数を同⼀としていますが、 絶対同⼀である必要はありません) s2 = w21h1 + w22h2 +w23h3 + θ2 O O O O O O O

- 61. ニューラルネットワークの出⼒層には 2つのユニット, Z1, Z2があり Z1は「0」, Z2は「1」を検出する という意図がある

- 62. ここで、⼤事なことは

- 66. Z1 Z2 1 0 出⼒層 画像 「0」 計算 z1 z2 出⼒ 理想値 出⼒の誤差の評価として 数字「0」が読まれたとき: e = {(1-z1) + (0-z2) } 2 2

- 67. Z1 Z2 0 1 出⼒層 画像 「1」 計算 z1 z2 出⼒ 理想値 出⼒の誤差の評価として 数字「1」が読まれたとき: e = {(0-z1) + (1-z2) } 2 2

- 69. 0 1画像 画像 Z1 Z2 Z1 Z2 e = {(0-z1) + (1-z2) }e = {(1-z1) + (0-z2) } 2 22 2

- 70. 重みと閾値の決め⽅と⽬的関数

- 76. ニューラルネットワークの原理

- 80. 次回、誤差逆伝搬法を⾒ていきます

- 81. Appendix

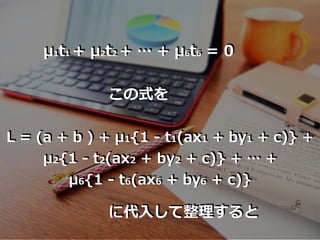

- 82. ti (i=1,2,..,6) に対して L = (a + b ) + μ1{1 - t1(ax1 + by1 + c)} + μ2{1 - t2(ax2 + by2 + c)} + … + μ6{1 - t6(ax6 + by6 + c)} について、a, b, cの最⼩値を求める。 これは、得られるμ1, μ2, … , μ6の式について その最⼤値を求める。 μ1, μ2, … , μ6 >0

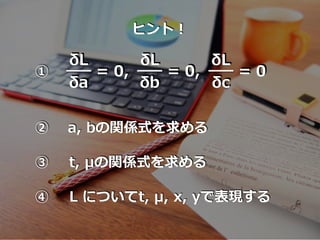

- 84. ヒント! δL δa = 0, δL δb = 0, δL δc = 0① ② a, bの関係式を求める ③ t, μの関係式を求める ④ L についてt, μ, x, yで表現する

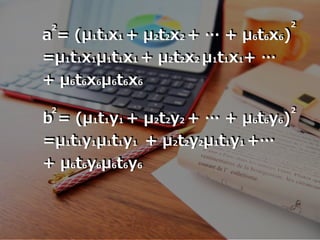

- 85. δL δa = a - μ1t1x1 - μ2t2x2 - … - μ6t6x6 = 0 δL δb = b - μ1t1y1 - μ2t2y2 - … - μ6t6y6 = 0 δL δc = - μ1t1 - μ2t2 - … - μ6t6 = 0 a = μ1t1x1 + μ2t2x2 + … + μ6t6x6 b = μ1t1y1 + μ2t2y2 + … + μ6t6y6 上記の式から... μ1t1 + μ2t2 + … + μ6t6 = 0

- 86. μ1t1 + μ2t2 + … + μ6t6 = 0 この式を L = (a + b ) + μ1{1 - t1(ax1 + by1 + c)} + μ2{1 - t2(ax2 + by2 + c)} + … + μ6{1 - t6(ax6 + by6 + c)} に代⼊して整理すると

- 87. L = - 1/2(a + b ) + (μ1 + μ2 + … + μ6) となる 2 2 ここで a = μ1t1x1 + μ2t2x2 + … + μ6t6x6 b = μ1t1y1 + μ2t2y2 + … + μ6t6y6 であるから a , b はそれぞれ 2 2

- 88. a = (μ1t1x1 + μ2t2x2 + … + μ6t6x6) =μ1t1x1μ1t1x1 + μ2t2x2 μ1t1x1+ … + μ6t6x6μ6t6x6 b = (μ1t1y1 + μ2t2y2 + … + μ6t6y6) =μ1t1y1μ1t1y1 + μ2t2y2μ1t1y1 +… + μ6t6y6μ6t6y6 22 2 2

- 89. Lを, xi, yi, ti, μi だけの式で表せば L = - 1/2{μ1μ1t1t1(x1x1+y1y1 )+ μ1μ2t1t2(x1x2+y1y2 )+ μ1μ3t1t3(x1x3+y1y3 )+ …+μ6μ6t6t6(x6x6+y6y6 )} + (μ1 + μ2 + … + μ6)

- 90. 条件式 L = - 1/2{μ1μ1t1t1(x1x1+y1y1 )+ μ1μ2t1t2(x1x2+y1y2 )+ μ1μ3t1t3(x1x3+y1y3 )+ …+μ6μ6t6t6(x6x6+y6y6 )} + (μ1 + μ2 + … + μ6) μ1t1 + μ2t2 + … + μ6t6 = 0 のもと の最⼤値を求めれば良い ※これがExcelシート上の計算となっている

- 91. EoF

![ハイパボリックタンジェント

双曲線正接関数

ロジスティック関数と同様の性質

が、値域が[-1,1]になり

より滑らかな関数となっていて

収束がロジスティックより速い

(計算が速く処理できる)

ロジスティック関数と総称して

シグモイド関数と呼ぶ](https://image.slidesharecdn.com/casuallearningmachinelearningwithexcelno5-200817061556/85/Casual-learning-machine-learning-with_excel_no5-29-320.jpg)