[DL Hacks輪読] Semi-Supervised Learning with Ladder Networks (NIPS2015)

- 1. Semi-Supervised Learning with Ladder Networks DL Hacks Paper Reading, 2016.1.7 Yusuke IWASAWA

- 2. 書誌情報 • Proc. NIPS2015 and arXiv • arXivの方が若干詳しいのでオススメ • Authours: • Antti Ramsus, Harri Valpola, Mikko Honkala, Mathias Berglund, and Tapani Raiko • #citations: 10 • 選定理由 • 精度が良い • 半教師、教師なし学習界隈の戦いがすごい

- 3. Abstract • Ladder Network [Valpola, 2015]を応用したDeepでSemi-supervised なモデルを提案 • 提案手法は、階層的潜在空間モデルをdenoising functionの 学習を通して効率的に学習可能 • 精度がとても良い • MNISTとCIFAR-10の半教師あり学習でstate-of-the-art • Permutation-MNISTでもstate-of-the-art

- 4. Introduction: Motivations • 教師ありは強力、しかし教師なしデータも有効活用したい • もっとも単純な方法の1つは潜在空間モデルを利用すること • Ex. Auto Encoderで入力データを潜在空間に飛ばす+Fine Tuning • ただし、単層の潜在空間だと表現力足りない -> Deepにしたい • Deepにする方法では、sDA + Fine Tuningがもっとも一般的 • sDAではタスクを解くのに不必要な情報も保存してしまう • Ex. 位置などのピクセルレベルの情報 -> Deepな潜在空間モデルを解く別の方法が必要

- 5. Introduction: 提案手法 Semi-Supervised Ladder Network まず [Valpola, 2015]を参考にこいつを 説明します

- 6. Ladder Network: 概要 • 潜在空間モデルをUnsupervised に学習する方法 • ハシゴみたいな形してるので Ladder Network • sDAと比較すると、Encoderと Decoderの間にConnectionが張 られている • 青: Encoder • オレンジ: Decoder Cited From “From Neural PCA to Deep Unsupervised Learning”

- 7. Ladder Network: 何をするのか • 結論から言えば、Denoising Source Separationをする • これ自体2005年の論文で発表された方法 • 複数の情報が混ざった観測信号から元の複数の情報源を取り出す方法 • 40ページある • Source separationもRepresentation learningも入力をうまく分解するとい う観点では同じ(岩澤解釈) • DSS: ノイズを加えた潜在変数z~ から加える前の潜在変数zを再 構成する • sDA: ノイズを加えた入力から1つ前の層を再構成する

- 8. Ladder Network: 何をするのか(図示) • 各層でノイズ付きのh~(l)から ノイズを入れる前のh(l)を再 構成(h^(l)) • 誤差関数C(l)は2乗和誤差 • 誤差関数の重み付き和を 小さくするようなg(l)を学習 する • C = Σλ(l) C(l)

- 9. Ladder Network: 何をしてるのか • Denoising function gの学習により階 層的潜在変数モデルを学習 • [Bengio, 2013] denoising functionがわかれば確率密 度を推定できる • 良いgを求めることと良いモデル (分布の良い近似)を得ることは 本質的に近い関係にある 図: Denoisingの周辺尤度の関係 P(z) P(z~) g

- 10. Ladder Network vs. Auto Encoder • Auto Encoder(複数レイヤを一気に学習) • そもそも学習が難しい • 学習が遅い • Auto Encoder(Layer Wise) • 細部まで再現しようとする (顔のような概念を獲得してもReconstruction Errorは下がらない) • Deepにすると上の層で誤差が蓄積する • Ladder Network • 上の層はより抽象的な情報だけに集中できる (細部の再構築は下の層に任せることができる)

- 11. Semi-supervised Ladder Net • ラベル有りデータについ てはその情報を利用する • 純粋にクラス分類コスト を追加して学習 • C = Ce + Σλ(l) Cd (l) • 学習にはCorrupted Encoder(左)を利用 • 予測ではClean Encoder (右)を利用する Corrupted Encoder Decoder Clean Encoder Ce

- 12. Implementation of the Model 1. Encoderを訓練※(CorruptedとCleanの2種類) • MLPでもCNNでもRNNでも良い • 2種類といっても重みは共有してるので実際は1種類 2. 各層で条件付き分布 𝑝(𝑧 𝑙|𝑧 𝑙+1) を求める • 今回の実験ではガウス分布を仮定してそのパラメタをNNで求める 3. 2.の条件付き分布に乗ったノイズをうまくキャンセルするよ うな関数gを定義する • 次スライドで話します 4. Fully-labeled or Semi-supervisedな設定でネットワーク全体を SGDで学習する ※論文に”1. Train any standard feedforward neural networks”と書かれているのでたぶん 先に学習しておくんじゃないかなと思いますがちょっと微妙です

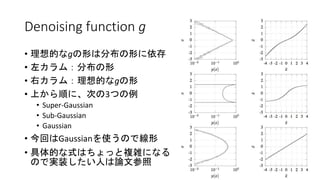

- 13. Denoising function g • 理想的なgの形は分布の形に依存 • 左カラム:分布の形 • 右カラム:理想的なgの形 • 上から順に、次の3つの例 • Super-Gaussian • Sub-Gaussian • Gaussian • 今回はGaussianを使うので線形 • 具体的な式はちょっと複雑になる ので実装したい人は論文参照

- 14. Γmodel: Special Case of Ladder Network • 一番上の層だけ再構築 • Decoderがいらなくなるの で実装が楽 • 結果で示すようにこれで もまぁまぁ精度良い 黒枠の中をそっくり無くす

- 15. Experimental Setup • Datasets: Permutation MNIST, MNIST, CIFAR-10 • Encoder: MLPとCNN • Baselines: いろいろ • Training: • Adam(lr=0.002) • Lr scheduling (linearly decreasing to zero at final epoch) • Minibatch size = 100 • The source codes: • https://github.com/arasmus/ladder

- 16. Results: Permutation MNIST (MLP) • 使ったラベル数によらずState-of-the-art • 特にラベル数が少ない場合に良い精度(エラー率でVAEの1/3)

- 17. Results: MNIST (CNN) • State-of-the-art • Full Labeledの評価がないのが若干気になる (Full Labeledなら普通にCNN使えばいい話な気もする

- 18. Results: CIFAR10 (CNN) • ラベルが限られてる場合は普通のCNNより良い • 特に少数ラベルの場合高精度

- 19. Conclusion and Future Direction • 複数の半教師ありタスクでstate-of-the-artなモデルを提案 • 今後は次の方針で進める予定 • どのようなEncoder+Decoderの組み合わせが適切か • 時系列方向での発展

![Abstract

• Ladder Network [Valpola, 2015]を応用したDeepでSemi-supervised

なモデルを提案

• 提案手法は、階層的潜在空間モデルをdenoising functionの

学習を通して効率的に学習可能

• 精度がとても良い

• MNISTとCIFAR-10の半教師あり学習でstate-of-the-art

• Permutation-MNISTでもstate-of-the-art](https://image.slidesharecdn.com/dlhacks-paper-reading-160107093848/85/DL-Hacks-Semi-Supervised-Learning-with-Ladder-Networks-NIPS2015-3-320.jpg)

![Introduction: 提案手法

Semi-Supervised

Ladder Network

まず [Valpola, 2015]を参考にこいつを

説明します](https://image.slidesharecdn.com/dlhacks-paper-reading-160107093848/85/DL-Hacks-Semi-Supervised-Learning-with-Ladder-Networks-NIPS2015-5-320.jpg)

![Ladder Network: 何をしてるのか

• Denoising function gの学習により階

層的潜在変数モデルを学習

• [Bengio, 2013]

denoising functionがわかれば確率密

度を推定できる

• 良いgを求めることと良いモデル

(分布の良い近似)を得ることは

本質的に近い関係にある

図: Denoisingの周辺尤度の関係

P(z)

P(z~)

g](https://image.slidesharecdn.com/dlhacks-paper-reading-160107093848/85/DL-Hacks-Semi-Supervised-Learning-with-Ladder-Networks-NIPS2015-9-320.jpg)