Curso

Imagem do autor

Já deixamos para trás a tarefa de melhorar os grandes modelos de linguagem (LLMs) e agora estamos focados em usá-los para criar aplicativos de IA que ajudem as empresas. É aí que entram as ferramentas de operações de modelos de linguagem grandes (LLMOps), que simplificam o processo de criar sistemas totalmente automatizados para construir e implementar soluções LLM na produção.

Neste artigo, vamos dar uma olhada em diferentes ferramentas, como APIs LLM, estruturas de ajuste fino, ferramentas de acompanhamento de experimentos, ecossistema de integração LLM, ferramentas de pesquisa vetorial, estrutura de serviço de modelos, plataformas de implantação e ferramentas de observabilidade. Cada ferramenta é excelente no que faz e foi projetada para resolver problemas específicos relacionados a LLMs.

O que é LLMOps?

LLMOps é uma área nova que se concentra na gestão operacional de grandes modelos de linguagem em ambientes de produção. É basicamente MLOps (operações de machine learning) especializado em linguagem e outros modelos multimodais.

Faça o curso Conceitos de Modelos de Linguagem Grandes (LLMs) para aprender sobre aplicações de LLM, metodologias de treinamento, considerações éticas e as pesquisas mais recentes.

LLMOps abrange todo o ciclo de vida dos grandes modelos de linguagem, incluindo coleta de dados, treinamento ou ajuste fino do modelo, testes e validação, integração, implantação, otimização, monitoramento e manutenção, além de colaboração. Ao estruturar projetos e automatizar processos, o LLMOps ajuda você a reduzir erros e dimensionar aplicativos de IA com eficiência, garantindo que os modelos sejam robustos e capazes de atender às demandas do mundo real.

Resumindo, as ferramentas LLMOps ajudam você a criar um sistema automatizado que coleta dados, ajusta o modelo com base neles, programa o desempenho do modelo, integra-o com dados externos, cria o aplicativo de IA, o implanta na nuvem e observa as métricas e o desempenho do modelo em produção.

O programa de habilidades Desenvolvimento de grandes modelos de linguagem tem 4 cursos que vão te ajudar a construir uma base sólida sobre como o LLM funciona e como você pode ajustar os LLMs pré-treinados.

Agora, vamos ver as principais ferramentas LLMOps disponíveis hoje em dia.

API

Acesse modelos de idioma e incorporação usando chamadas de API. Você não precisa implantar o modelo nem cuidar do servidor; só precisa fornecer uma chave API e começar a usar os modelos mais modernos.

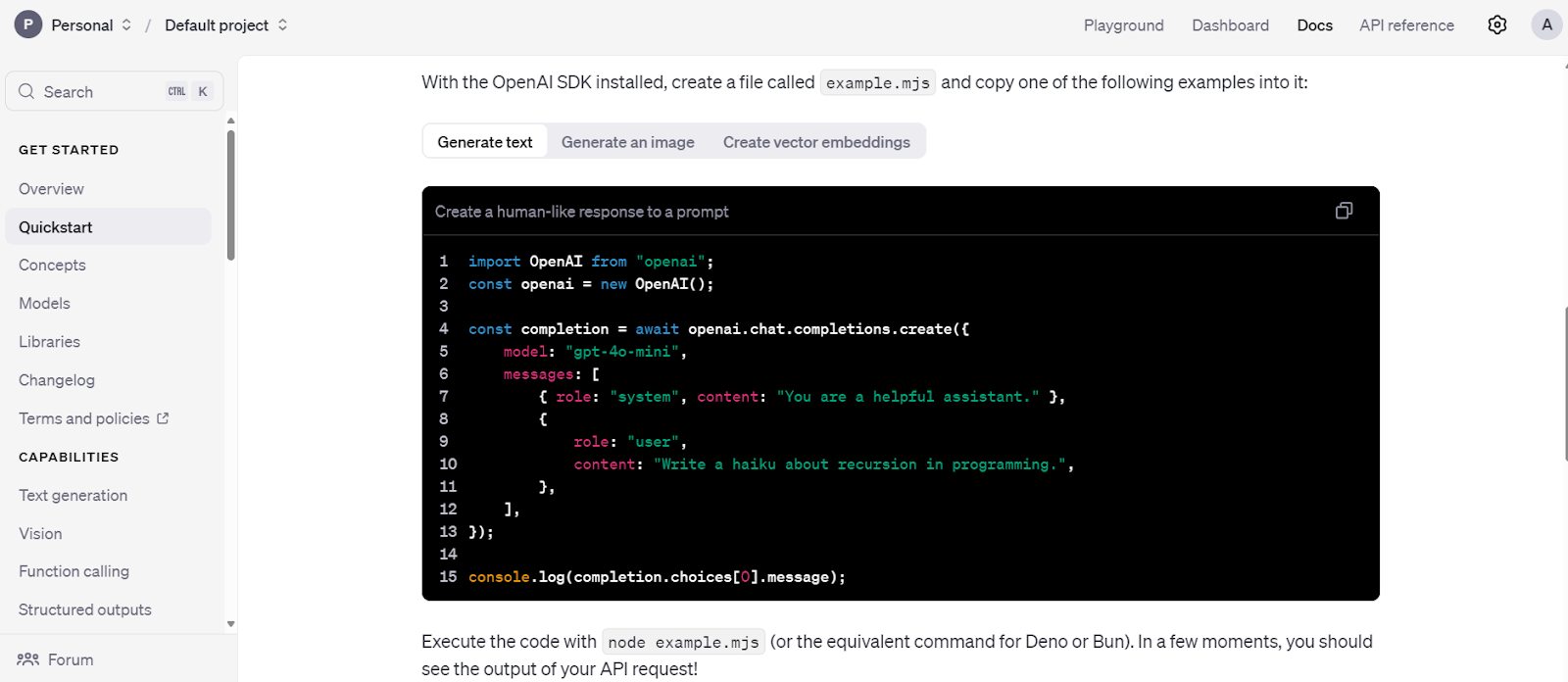

1. OpenAI API

A OpenAI oferece acesso à API para modelos LLM avançados, como GPT-4o e o1. Esses modelos podem ser usados por meio de um pacote Python ou comando CURL.

A API é uma solução ideal para startups sem uma equipe técnica para ajustar ou implantar modelos em produção. Ele dá acesso a modelos de linguagem, modelos multimodais, chamadas de função, saídas estruturadas e opções de ajuste fino. Além disso, você pode usar modelos de incorporação para criar seu próprio banco de dados vetorial. Resumindo, oferece um ecossistema de IA completo e barato.

Aprenda a usar a API Python da OpenAI para acessar LLMs de última geração seguindo o Tutorial da API GPT-4o da : Introdução à API da OpenAI.

Código de início rápido da API OpenAI. Fonte da imagem: Tutorial rápido - API OpenAI

2. API Antrópica

A API Anthropic é parecida com a API OpenAI, oferecendo acesso a vários modelos de linguagem e incorporação. Esses modelos podem ser usados para criar aplicativos RAG, integrar ferramentas, recuperar páginas da web, usar modelos de visão e desenvolver agentes de IA. Com o tempo, a Anthropic quer oferecer todas as ferramentas necessárias para criar e usar aplicativos de IA que funcionem direitinho.

Assim como a API da OpenAI, ela inclui proteções de segurança e ferramentas de avaliação para monitorar o desempenho do modelo.

Aprenda a usar a API Claude para acessar LLMs de alto desempenho seguindo o tutorial da API Claude Sonnet 3.5 : Introdução à API da Anthropic.

Código de início rápido da API Antropic. Fonte da imagem: Configuração inicial - Anthropic

Ajuste fino

Usando Python, ajuste os modelos básicos de linguagem grande em um conjunto de dados personalizado para adaptar o estilo, a tarefa e a funcionalidade do modelo para atender a requisitos específicos.

3. Transformadores

O Transformers da Hugging Face é uma estrutura bem conhecida na comunidade e na indústria de IA. É muito usado pra acessar modelos, ajustar LLMs com recursos limitados e salvar modelos. Ele oferece um ecossistema completo para tudo, desde o carregamento de dados até a avaliação de LLMs.

Com o Transformers, você pode carregar conjuntos de dados e modelos, processar dados, criar modelos com argumentos personalizados, treinar modelos e enviá-los para a nuvem. Depois, você pode colocar esses modelos em um servidor com só alguns cliques.

Faça o curso Introdução aos LLMs em Python para aprender sobre o panorama dos LLMs, a arquitetura do transformador, os LLMs pré-treinados e como integrar os LLMs para resolver problemas do mundo real.

Código de início rápido do Transformers. Fonte da imagem: Visita rápida (huggingface.co)

4. IA Unsloth

Unsloth AI é uma estrutura Python para ajustar e acessar grandes modelos de linguagem. Ele oferece uma API simples e um desempenho duas vezes mais rápido em comparação com os Transformers.

Feito com base na biblioteca Transformers, ele junta ferramentas extras pra facilitar o ajuste fino de grandes modelos de linguagem com recursos limitados. Uma característica marcante do Unsloth é a capacidade de salvar modelos em formato compatível com vLLM e GGUF com apenas uma linha de código, eliminando a necessidade de instalar e configurar bibliotecas como llama.cpp, pois ele cuida de tudo automaticamente.

Desbloquear código de inferência. Fonte da imagem: Inferência | Documentação do Unsloth

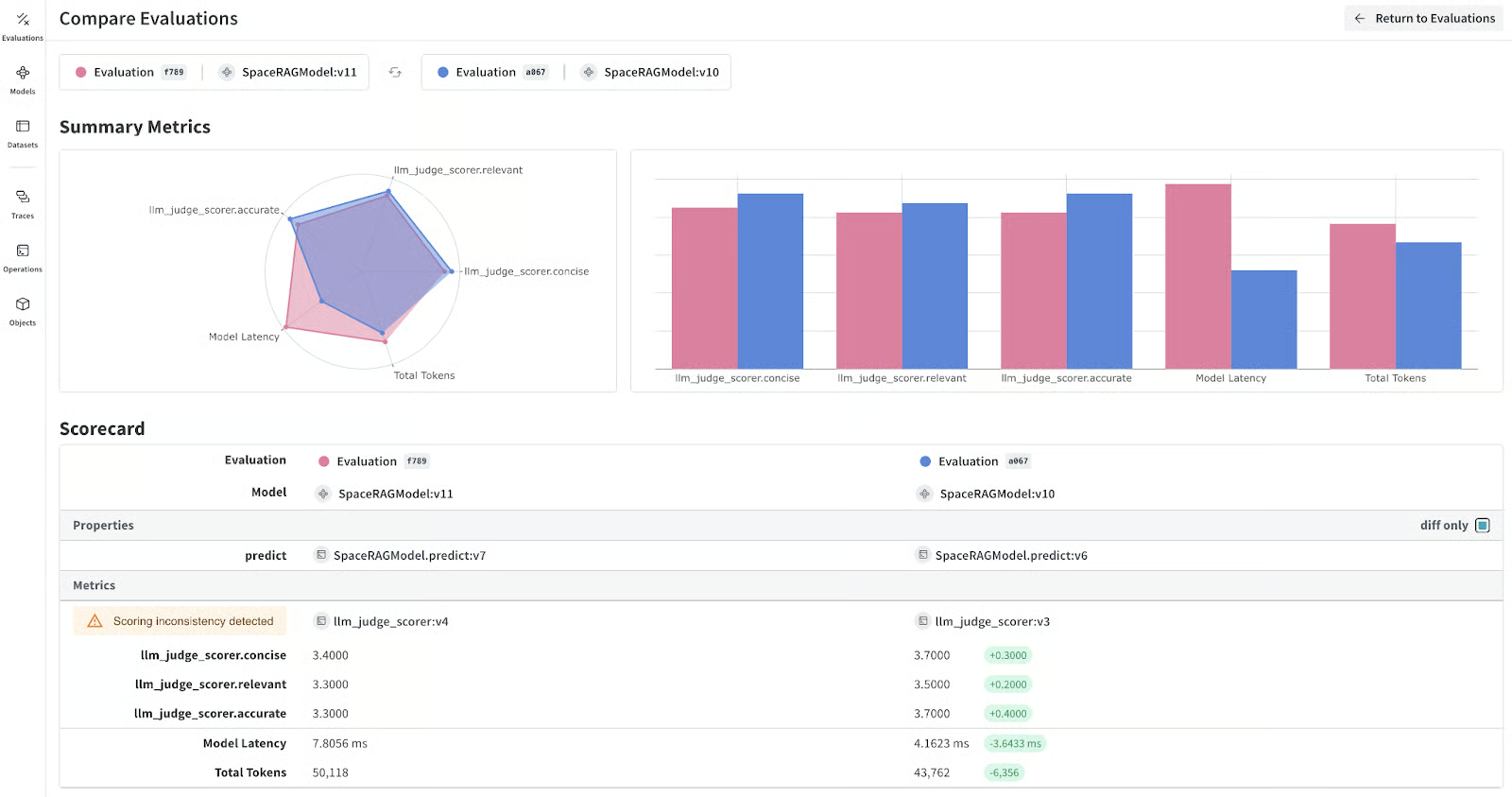

Programa de Experiências

Programa e avalie o desempenho do modelo durante o treinamento e compare os resultados.

5. Pesos e vieses

O Weights & Biases permite que você acompanhe o desempenho do modelo durante e após o ajuste fino para avaliar a eficácia. Ele também dá suporte ao programa de aplicativos RAG e ao monitoramento e depuração de LLMs.

A plataforma se integra perfeitamente a várias estruturas e ferramentas, incluindo Transformers, LangChain, PyTorch e Keras. Uma grande vantagem de usar o Weights & Biases é o painel super personalizável, que te deixa criar relatórios de avaliação de modelos e comparar diferentes versões de modelos.

Aprenda a organizar, registrar e analisar seus experimentos de machine learning usando o Weights & Biases seguindo o tutorial “Experimentação de machine learning com o ”: Uma introdução ao Weights & Biases.

Métricas do modelo LLM. Fonte da imagem: wandb.ai

Integração LLM

Integre o LLM com um banco de dados externo, um banco de dados privado e uma pesquisa na web. Você pode até criar e usar todo o aplicativo de IA usando essas estruturas. Resumindo, essas ferramentas são essenciais pra criar aplicativos complexos baseados em LLM que você pode usar na nuvem.

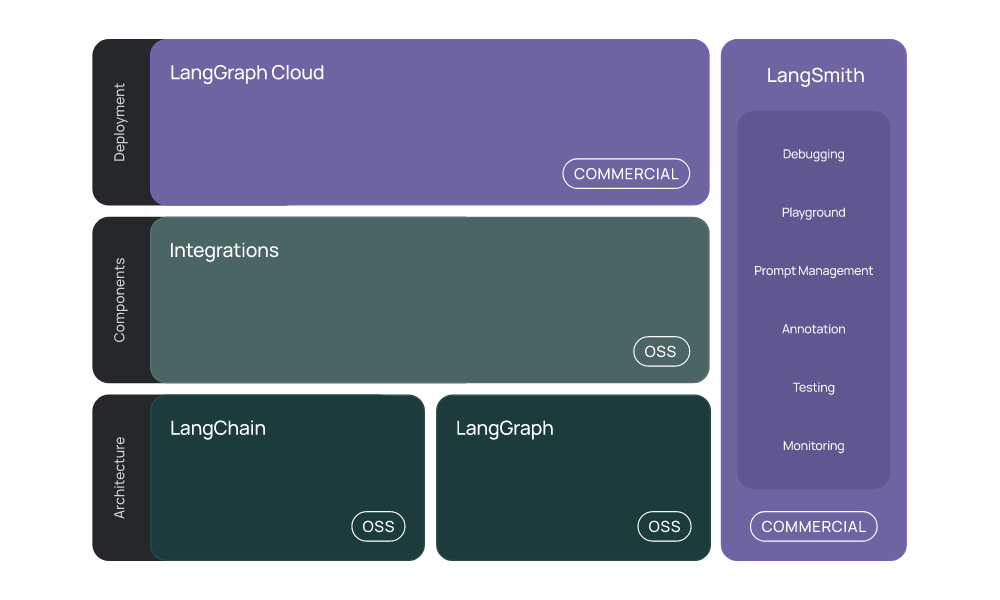

6. Langchain

LangChain é uma ferramenta popular para criar aplicativos de IA usando LLMs. Com só algumas linhas de código, você pode criar chatbots RAG que entendem o contexto direto nos notebooks Jupyter.

A LangChain agora oferece um ecossistema LLM completo:

- Integração: Ele dá suporte à integração com várias APIs de IA, modelos de chat, modelos de incorporação, carregadores de documentos, armazenamentos vetoriais e ferramentas.

- LangChain: Ele coordena várias ferramentas de integração e LLMs para criar aplicativos de IA.

- LangGraph: Ele foi feito pra criar aplicativos com vários atores e estado usando LLMs, modelando etapas como arestas e nós em um gráfico.

- LangGraph nuvem e LangSmith: Esses produtos comerciais permitem que você use serviços gerenciados para criar e implantar aplicativos baseados em LLM.

O LangChain simplifica o desenvolvimento de aplicativos com tecnologia LLM, oferecendo ferramentas, componentes e interfaces que facilitam o processo.

Faça o curso Desenvolvendo Aplicativos LLM com LangChain pra entender como criar aplicativos com inteligência artificial usando LLMs, prompts, cadeias e agentes no LangChain.

O ecossistema LangChain. Fonte da imagem: Introdução | 🦜️🔗 LangChain

7. LlamaIndex

O LlamaIndex é parecido com o LangChain, mas tem uma abordagem mais simples pra criar aplicativos RAG. Com só algumas linhas de código, você pode criar aplicativos RAG com histórico.

O LlamaIndex oferece integrações completas de API e armazenamento vetorial, permitindo o desenvolvimento de aplicativos LLM complexos e de última geração. Ele também tem um serviço gerenciado chamado LlamaCloud, que facilita a hospedagem de aplicativos de IA.

Aprenda a inserir, gerenciar e recuperar dados privados e específicos de domínios usando linguagem natural, seguindo o LlamaIndex do : Uma estrutura de dados para aplicativos baseados em modelos de linguagem grandes (LLMs) Tutorial do.

Guia avançado do LlamaIndex RAG. Fonte da imagem: RAG avançado com LlamaParse - LlamaIndex

Pesquisa vetorial

As ferramentas de pesquisa vetorial oferecem recursos robustos de armazenamento e recuperação, que são essenciais para a criação de aplicativos de geração aumentada por recuperação (RAG). Essas ferramentas permitem converter vários tipos de dados, como texto, imagens e áudio, em embeddings, que depois são guardados em bancos de dados vetoriais.

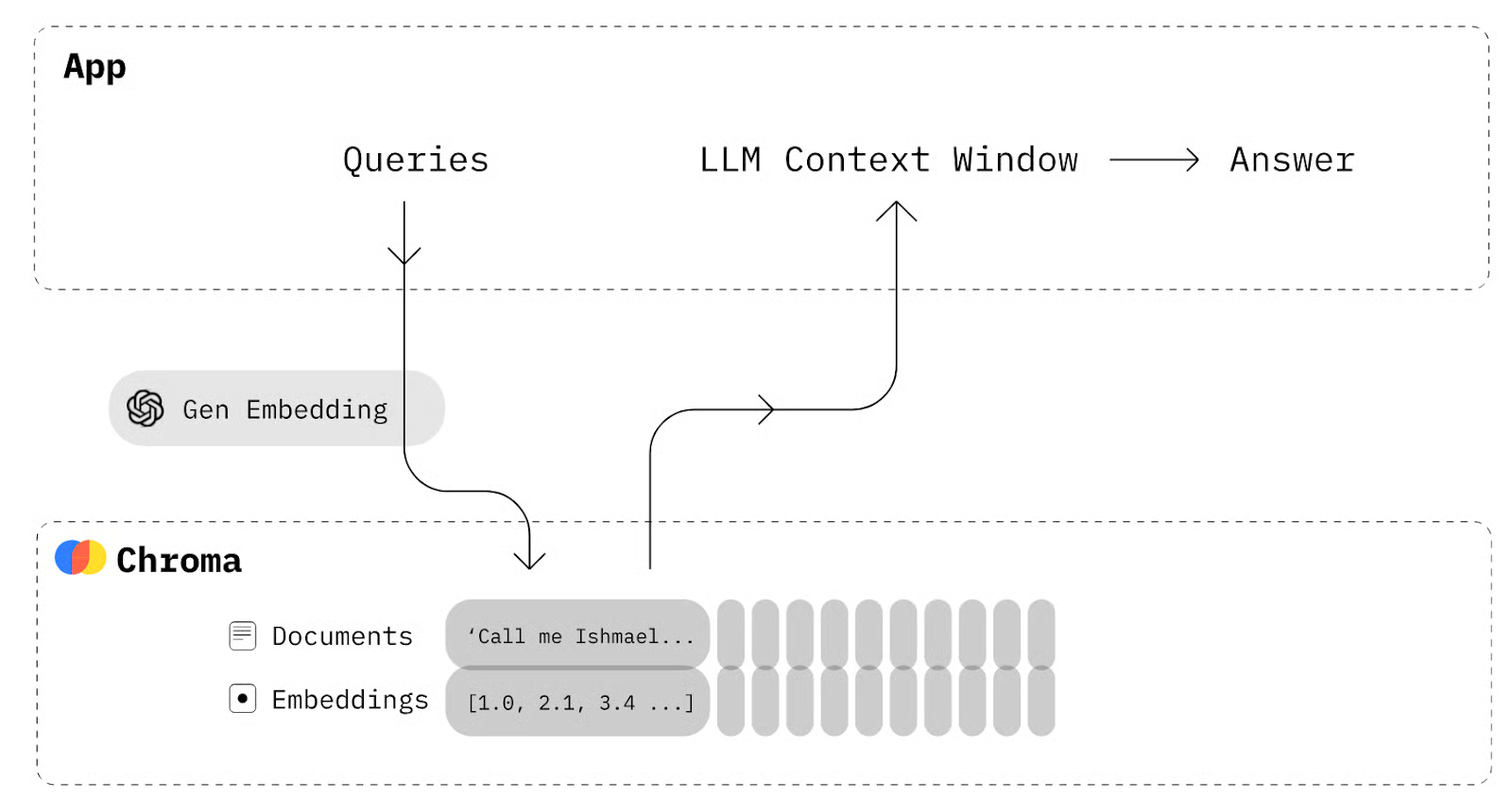

8. Chroma

Chroma é um banco de dados vetorial de código aberto nativo de IA. Isso facilita a criação de aplicativos LLM, permitindo que conhecimentos, fatos e habilidades sejam facilmente integrados.

Se você quer criar um aplicativo RAG básico que permita armazenar seus documentos como embeddings e depois recuperá-los para combinar com prompts, a fim de dar mais contexto ao modelo de linguagem, você não precisa do LangChain. Tudo o que você precisa é de um Chroma DB para salvar e recuperar os documentos.

Chroma DB diagram. Fonte da imagem: Chroma Docs (trychroma.com)

9. Qdrant

O Qdrant é um banco de dados vetorial de código aberto bem conhecido e um mecanismo de busca por similaridade que lida com vetores de alta dimensão. Oferece soluções locais, em nuvem e híbridas, tornando-o versátil para várias necessidades de implantação.

O Qdrant é super útil em aplicações como geração aumentada por recuperação, detecção de anomalias, pesquisa avançada e sistemas de recomendação. Sua API robusta permite fácil integração e gerenciamento de dados de texto, tornando-a uma ferramenta poderosa para desenvolvedores que desejam implementar recursos de pesquisa baseados em vetores.

Dá uma olhada nas 5 melhores bases de dados vetoriais para o seu caso específico. Eles oferecem uma API simples e um desempenho rápido.

Exemplo de introdução ao Qdrant. Fonte da imagem: Início rápido local - Qdrant

Servindo

Um componente essencial para sua aplicação é um mecanismo de inferência e serviço de alto rendimento para LLMs que seja compatível com uma ampla gama de recursos de computação, incluindo GPUs, TPUs, XPUs e muito mais. Essas ferramentas também são compatíveis com servidores compatíveis com OpenAI, permitindo que você use a API da OpenAI para acessar o modelo servido de forma integrada.

10. vLLM

A vLLM é uma biblioteca robusta de código aberto feita pra inferência e serviço eficientes de modelos de linguagem grandes. Ele lida com os desafios de implantar LLMs, como alto consumo de memória e custos computacionais, usando técnicas inovadoras de gerenciamento de memória e estratégias dinâmicas de agrupamento.

Uma das melhores características do vLLM é o algoritmo PagedAttention, que melhora bastante a taxa de transferência e reduz o desperdício de memória. Ele oferece um rendimento até 24 vezes maior do que as soluções tradicionais, como o Hugging Face Transformers.

Exemplo de início rápido do vLLM. Fonte da imagem: Início rápido — vLLM

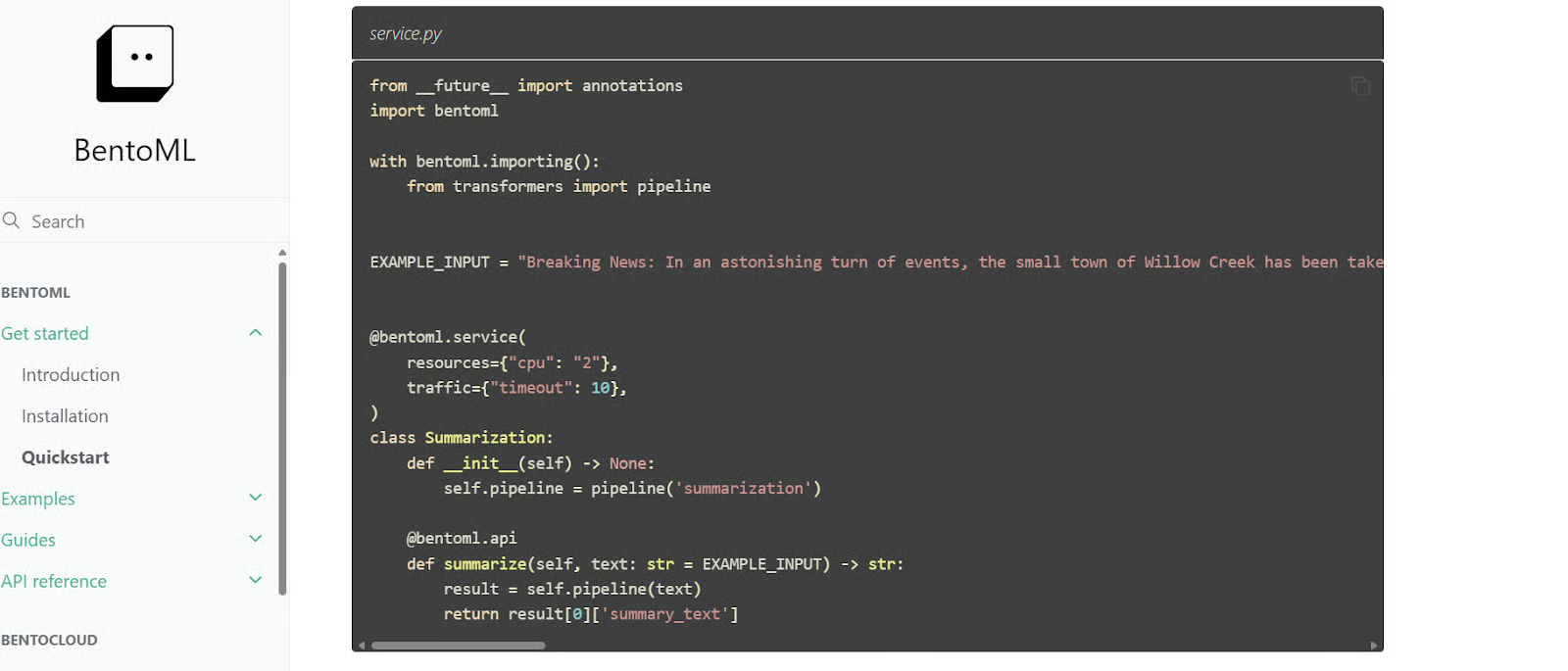

11. BentoML

BentoML é uma biblioteca Python para criar e servir LLMs, oferecendo mais opções de personalização para desenvolver aplicativos de IA do que o vLLM. Inclui o BentoCloud, um serviço gerenciado que facilita a implantação e o monitoramento de modelos na nuvem, com um nível gratuito disponível para começar.

O BentoML automatiza várias etapas complexas na implantação de modelos, reduzindo bastante o tempo necessário para passar os modelos do desenvolvimento para a produção.

Código de início rápido do BentoML. Fonte da imagem: Quickstart - BentoML

Implantação

Você pode implantar seu LLM diretamente na nuvem ou criar um aplicativo de IA integrado e, em seguida, implantá-lo. Para isso, você pode escolher qualquer grande provedor de serviços em nuvem. Mas, as ferramentas abaixo foram feitas especialmente para LLMs e implantação de IA, oferecendo um recurso de implantação mais fácil e eficiente.

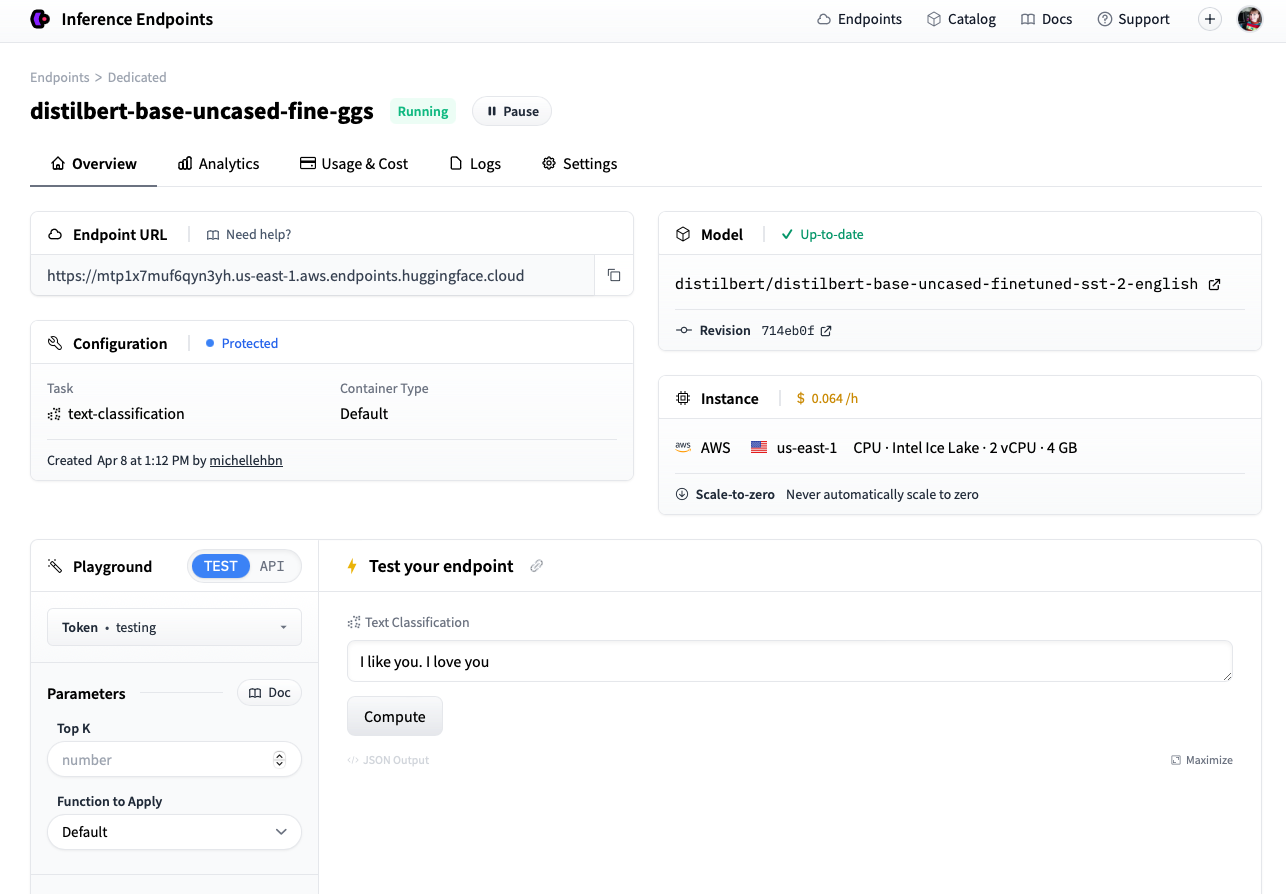

12. Pontos finais de inferência

Se você curte o ecossistema Hugging Face, vai adorar os Hugging Face Inference Endpoints. Esse serviço de implantação permite que você utilize qualquer modelo do hub de modelos Hugging Face, incluindo modelos privados, para uso em produção. É só escolher o seu provedor de serviços em nuvem e o tipo de máquina de computação, e em poucos minutos seu modelo estará pronto para uso.

O Inference Endpoints tem um painel dedicado que permite criar pontos finais e monitorar modelos em produção, oferecendo uma solução segura e eficiente para implantar modelos de machine learning.

Implantando um modelo usando o endpoint Hugging Face Inference. Fonte da imagem: Criar um Endpoint (huggingface.co)

13. Qualquer escala

A Anyscale usa o Ray Serve no backend para oferecer inferência de modelo rápida e de alto rendimento. Como uma plataforma de computação totalmente gerenciada e escalável, a Anyscale permite que você carregue dados, treine modelos, avalie e utilize modelos, gerencie serviços, monitore modelos e controle o acesso. É uma plataforma MLOps completa, construída no ecossistema de código aberto Ray, que simplifica todo o ciclo de vida das aplicações de IA.

Espaço de trabalho Anyscale. Fonte da imagem: Plataforma de computação unificada para aplicativos de IA e Python | Anyscale

Observabilidade

Depois que seus LLMs forem implantados, é super importante monitorar o desempenho deles na produção. As ferramentas de observabilidade acompanham automaticamente seu modelo na nuvem e avisam se o desempenho cair muito.

14. Claro

Evidentemente, é uma estrutura de observabilidade de código aberto para ML e MLOps. Permite avaliar, testar e monitorar aplicativos de ML e pipelines de dados. Ele dá suporte a modelos preditivos gerais e também a aplicativos de IA generativa.

Com mais de 100 métricas integradas, ele oferece detecção de desvio de dados e avaliação de modelos de ML. Ele também pode gerar relatórios de avaliação de dados e modelos, conjuntos de testes automatizados e painéis de monitoramento de modelos.

Claro que é monitoramento de modelo. Fonte da imagem: evidentlyai.com

15. Fiddler IA

O Fiddler AI é uma plataforma de observabilidade de IA que monitora, explica, analisa e melhora modelos LLM, modelos geradores de imagens e aplicações gerais de IA. Ele detecta e resolve desvios de modelo, valores atípicos e problemas de integridade de dados por meio de alertas em tempo real e depuração explicável com inteligência artificial, o que ajuda as equipes a identificar e resolver problemas assim que eles aparecem.

Diagrama de observabilidade do Fiddler AI. Fonte da imagem: Observabilidade LLM | Fiddler AI

Agora que você já conhece várias ferramentas LLMOPs, é hora de criar um projeto LLM a partir da lista de 12 projetos LLM para todos os níveis das postagens do blog.

Conclusão

O campo das LLMOps ainda está em desenvolvimento e há muito barulho no espaço da IA. Neste artigo, a gente explorou as 15 principais ferramentas LLMOps que estão na vanguarda do setor.

Embora tenhamos falado sobre as ferramentas essenciais e populares para criar, avaliar e implementar aplicativos de IA na nuvem, muitas categorias ainda não foram abordadas. Isso inclui ferramentas de operação de machine learning para CI/CD, orquestração de fluxo de trabalho, controle de versão de modelos e dados, Docker, Kubernetes e muito mais. Você pode saber mais sobre essas categorias lendo a postagem do blog 25 principais ferramentas de MLOps que você precisa conhecer em 2026.

Se você é novo no LLMOps, é super recomendável começar com a API OpenAI e criar um produto mínimo viável!

Desenvolva habilidades de MLOps hoje mesmo

Perguntas frequentes

Posso usar várias ferramentas LLMOps juntas em um projeto ou devo usar só uma?

Sim, você pode usar várias ferramentas LLMOps juntas, pois elas geralmente tratam de diferentes aspectos do ciclo de vida da IA. Por exemplo, você pode usar uma API para acessar modelos de linguagem (como a API OpenAI), uma estrutura de ajuste fino (como Transformers) e uma ferramenta de serviço (como BentoML) para o mesmo projeto. Integrar ferramentas complementares pode ajudar a simplificar os fluxos de trabalho.

Como eu decido qual ferramenta LLMOps usar no meu projeto?

Depende das suas necessidades específicas. Se você está começando do zero e quer acesso fácil a modelos, uma API como a OpenAI pode ser ideal. Para usuários avançados, modelos de ajuste fino, como Transformers ou Unsloth AI, são ótimas opções. Ao escolher as ferramentas, pense nos objetivos do seu projeto, no seu conhecimento técnico e nos requisitos de escalabilidade.

Que habilidades preciso ter pra usar bem as ferramentas LLMOps?

Você vai precisar entender bem sobre grandes modelos de linguagem, programação Python e infraestrutura básica de nuvem. Conhecer frameworks como PyTorch ou Hugging Face também pode ajudar, principalmente se você quiser ajustar modelos ou criar aplicativos de IA complexos.

Tem algum custo a se pensar ao usar as ferramentas LLMOps?

Muitas ferramentas LLMOps oferecem níveis gratuitos ou opções de código aberto, mas os custos podem aumentar com base no uso, especialmente para chamadas de API, implantações em nuvem ou serviços gerenciados. Dá uma olhada nos modelos de preços e escolhe a melhor ferramenta pro seu orçamento e tamanho do projeto.

Como posso monitorar o desempenho dos meus modelos de IA implantados?

Ferramentas como Evidently e Fiddler AI foram feitas pra monitorar e observar modelos. Eles permitem que você acompanhe métricas de desempenho, detecte desvios de dados e receba alertas se a precisão do seu modelo cair. Essas ferramentas ajudam a garantir que seus modelos implantados continuem funcionando bem na produção.

Sou um cientista de dados certificado que gosta de criar aplicativos de aprendizado de máquina e escrever blogs sobre ciência de dados. No momento, estou me concentrando na criação e edição de conteúdo e no trabalho com modelos de linguagem de grande porte.